Sztuczna inteligencja i IBM – rozmowa z Piotrem Pietrzakiem – CTO w IBM

Jesteśmy po kolejnej rocznej konferencji przygotowana przez dużego gracza – tym razem Apple. Pewnie jak spodziewasz się również tam było o machine learning. Na przykład pojawił się nowy produkt Apple HomePod (zintegrowany z Siri) który podobnie ma konkurować z Amazon Echo czy Google Home. Siri będzie działać jeszcze lepiej.

W iOS11, to jest system operacyjny dla iphone, który ma pojawić się we wrześniu 2017, będzie wbudowany Core ML umożliwiający uruchomienie modeli na telefonie. Apple stawia na to, żeby taki model był uruchamiany na komórce. Dlaczego to jest ważne? Chodzi o dane, pamiętasz, że dane to jest nowoczesny surowiec. Wysłanie ich na zewnątrz zawsze wiąże się z ryzykiem.

Na końcu podcastu polecam miejsca gdzie możesz posłuchać więcej na ten temat.

Sztuczna inteligencja w IBM

Już nie przedłużam i przechodzimy do dzisiejszego tematu. Piotr Pietrzak który jest CTO w IBM zgodził się podzielić się swoim doświadczeniem. Dowiesz się więcej o słynnej grze kiedy maszyna wygrały w szachy Garry Kasparov’ego, o zwycięstwu Watson w grze Jeopardy i wele innych tematów. Gorąco zapraszam.

Vladimir:

Cześć Piotr. Przedstaw się słuchaczom… Kim jesteś, czym się zajmujesz, gdzie mieszkasz?

Piotr:

Cześć Vladimir. Witam wszystkich słuchaczy. Nazywam się Piotr Pietrzak, na co dzień jestem dyrektorem do spraw technologii i innowacji w firmie IBM. Na co dzień mieszkam w Legionowie, sympatycznej podwarszawskiej miejscowości. Cały czas chce zakładać że jestem człowiekiem nieco cyborgiem, na pewno jestem komputerowym geekiem i chyba w skrócie tyle.

Vladimir:

Co ostatnio czytałeś i czego nauczyłeś z tej książki?

Piotr:

Ostatnio wróciłem do książki, która nauczyła mnie jak bardzo skomplikowany jest nasz umysł czyli pułapek myślenia. Książka, którą bardzo serdecznie polecam wszystkim którzy chcą otworzyć się na to jak łatwo można zmanipulować nasz mózg, jak łatwo można zmanipulować sposób naszego myślenia czyli pułapki myślenia. To jest książka napisana przez Daniela Kahnemana, który jest noblistą. Z tej serii jest również kilka innych książek, które wyjaśniają pewnego rodzaju zjawiska nad którymi na co dzień nie zastanawiamy.

Vladimir:

Pracujesz w IBM jako techniczny dyrektor albo po angielski to brzmi CTO. Jak wygląda Twoja praca? Jakiego typu problemy rozwiązujesz i w jaki sposób?

Piotr:

Niestety odpowiedź na to pytanie nie jest prosta. Dlatego że zajmuję się stosunkowo szerokim spektrum rzeczy i rozwiązań. Począwszy od wsparcia lokalnego firmy w jaki sposób dostarczać, marketingować nowe rozwiązania, produkty czy technologie do polskiego rynku. Czyli w jaki sposób z technologii czy z konkretnego produktu zrobić rozwiązanie, które będzie akceptowalne bądź chętne do nabywania przez naszych klientów, ale żeby oni chcieli to nabywać, musi być zbudowana pewna ścieżka wartości dla nich. Czyli co tak naprawdę mają z tej technologii i co technologia im pozwala rozwiązać w codziennym życiu biznesowym. I to jest jeden obszar czyli coś co możemy nazwać strategią.

Drugim obszarem jest działanie bezpośrednie, współpraca z klientami w projektach. W chwili obecnej głównie koncentruję się na cloud computingu na rozwiązaniach typu watson i sztucznej inteligencji ewentualnie można to nazywać czymś co w chwili obecnej nazywane jest cognitive computing. Ja, przyznam szczerze, nie lubię tłumaczenia na język polski słowa cognitive, bo to oznacza poznawczy. Poznawczy system komputerowy brzmi trochę sztywno, przyznam szczerze, więc tutaj angielskie nazewnictwo bardziej mi przypada do gustu, przynajmniej z punktu widzenia osoby technicznej. Pewnie dla osób, które nie są związane z technologią może to być mniej sympatyczne do zaakceptowania czy absorbcji. Tutaj przede wszystkim koncentruję się nad tym w jaki sposób nowe technologie, po pierwsze, pomagają wnieść nową wartość biznesową klientowi do jego biznesu, bądź też jakie nowe usługi i produkty dana firma może wypuścić na rynek, niezależnie czy to w kanale “business to business” czy “business to consumer” (czyli klient indywidualny) z użyciem nowych technologii. To jest niesamowicie ciekawy obszar, chyba najbardziej pasjonujący dla mnie, mimo wszystko, dlatego że widzimy bardzo wyraźnie przenikanie się branż.

Wyobraź sobie, mam na co dzień okazję bycia członkiem komisji innowacyjności Polskiej Izby Przemysłu Chemicznego. Czy ja wiem coś o chemii – kompletnie nie. Czy ja wiem coś o EIoT – bardzo dużo. Czy ja wiem coś o systemach informatycznych – chce wierzyć, że sporo. I w związku z tym, że następuje we wszystkich branżach przenikanie się rozwiązań, w komisji innowacyjności jestem w stanie podpowiadać jakie rozwiązania techniczne mogą rozwiązać jakie problemy.

Na przykład, na instalacji chemicznej, w procesie wytwórczym czy przetwórczym ropy naftowej, jakimi rozwiązaniami może nas zaskoczyć za chwile na rynku firma produkująca nawozy sztuczne albo środki ochrony roślin. Albo w jaki sposób nowe technologie mogą przyśpieszyć i obniżyć koszty, na przykład, prac nad nawozami płynnymi. I to są rzeczy, które z punktu widzenia przetwarzania informacji, przetwarzania i budowy nowych rozwiązań są moją kompetencją. Po drugiej stronie mam partnerów, których główną kompetencją jest wiedza branżowa, czyli z czego jest zbudowany dany związek chemiczny, co musi być spełnione żeby on działał, wszystkie te rzeczy związane z branżą. I to są chyba najbardziej ciekawe rozwiązania, którymi się zajmuję.

A trzeci obszar to jest oczywiście reprezentacja firmy IBM w obszarze, z jednej strony wszelkiego rodzaju konferencji branżowych, mówienia o naszych najnowszych technologiach, ale również taki obszar który bardzo często przez wiele osób nie jest dostrzegany, chociaż jest coraz bardziej popularny w Polsce – to współpraca z funduszami inwestycyjnymi, inkubatorami oraz akceleratorami przedsiębiorczości na terenie kraju.

Czyli takie trzy głównych filary.

Vladimir:

Powiedziałeś kilka ciekawych rzeczy, będę pytał o nie później.

Myślę, każdy się zgodzi że IBM jest bardzo słynną firmą w temacie sztucznej inteligencji. I są ku temu powody. Większość prezentacji która mówi o sztucznej inteligencji, zwłaszcza z tak zwanej wąskiej lub słabej sztucznej inteligencji, która w uproszczeniu oznacza, że komputer jest lepszy niż człowiek w pewnym obszarze – zwykle zaczyna się od przykładu gry w szachy. Słynna gra pomiędzy Garri Kasparowem i Deep Blue w maju 1997.

To były początki, ale ciekawe jest co było pod spodem, dlaczego Deep Blue był lepszy? I przy okazji zapytam, bo Deep Learning jest bardzo gorącym tematem. Teraz gdy pojawia się słowo Deep to automatycznie wiąże się z Deep Learning. Jeżeli nie używano Deep Learning pod spodem (bo to pojęcie pojawiło się trochę później), to czemu Deep? Co autorzy mieli na myśli czy być może to zbieg okoliczności?

Piotr:

Po pierwsze, nie uważam i nie utożsamiam komputera Deep Blue ze sztuczną inteligencją. To znaczy, jezeli coś jest bardzo wydajną maszyną obliczeniową niekoniecznie spełnia paradygmat tego czym określamy sztuczną inteligencję. To, że komputer wygrywa z komputerem w gry, nie oznacza że jest inteligentniejszy od komputera. To oznacza że umie lepiej rozwiązywać pewien problem postawiony w danej grze. Wynika to z bardzo prostej rzeczy – z ewolucji. Dlatego że komputery, które rozwiązują problemy chociażby optymalizacyjne zostały zaprogramowane w celu wygrania w szachy, rozwiązania problemów komiwojażera albo przynajmniej ich mocnego optymalizowania albo przynajmniej wygranie w grę go.

Człowiek w trakcie swojej ewolucji nie ewoluował po to, żeby być mistrzem w rozwiązywaniu zagadek matematycznych, czy grania w szachy czy gry w go. Więc pewne obszary nie wymagają, nazwijmy to, sztucznej inteligencji żeby być w tym dobrym jak komputer. Czyli wymagają dużej mocy obliczeniowej, która umożliwia, po pierwsze, z wyprzedzeniem wykonywanie pewnych kalkulacji, natomiast na ile to ma związek ze sztuczną inteligencją, przyznam szczerze, zebym bardzo polemizował.

Deep Blue wydaje mi się bardziej był przykładem maszyny, nazwijmy to 32 węzłowego klastra obliczeniowego, zbudowanego na maszynach typu RS/6000 bazujących na procesorach IBM Power w architekturze RISC, które dysponowały dużą mocą obliczeniową, dzięki czemu mogły przewidzieć wiele kombinacji ruchów do przodu. Z tyłu – bazę danych, która była zgromadzoną informacją o dotychczasowych partiach szachowych, na to nałożony model analityczny, który mógł z jednej strony przeliczać wiele różnych kombinacji i robić wiele symulacji versus to co się dzieje w danym momencie na szachownicy. Jeżeli popatrzymy na możliwości obliczeniowe ówczesnego Deep Blue który, z tego co pamiętam, zachował się w teście LINPACK z wydajnością około 11 czy 12 gigaflopów.

I popatrzymy na to z czym mamy do czynienia w chwili obecnej, gdzie konsola do gier, którą mam w domu, ma moc obliczeniową na poziomie 1,2 teraflopa w górę, to znaczy że przez 20 lat przeskoczyliśmy pewną przepaść między tym co mogliśmy kiedyś, a tym co mamy teraz.

Zapytałeś również o nazwę. Ta nazwa nie była przypadkowa. Deep Blue nie miał nic wspólnego, jeżeli chodzi o nazwę, z Deep Learningiem, natomiast Deep Blue był nazwą zaczerpniętą przez twórcę i projektanta tego rozwiązania z ksiązki, gdzie nazwa komputera pochodzi od fikcyjnego komputera, który był przytaczany w książce pod tytułem Autostopem przez Galaktykę. Tamten komputer nazywał się Deep Thought czyli “głębokie myślenie”, i nazwa, zaczerpnięta z książki, została zmodyfikowana na Deep Blue czyli “głęboki niebieski”.

Vladimir:

Ciekawa opinia. Z twoich słów bardziej brzmi, że wygrały w szachy nie dlatego że maszyna była inteligentna, tylko posiadała bardzo dużą moc obliczeniową.

Piotr:

Tak, żeby móc przekalkulować duże ilości ruchów do przodu. Ale również mieć z tyłu bazę danych, która umożliwia analizę, związaną z tym jaki ruch czy jakie kombinacje będą optymalne jako następne. Nie powiedziałbym że zagadnienia optymalizacyjne dotyczą bezpośrednio zagadnień związanych z samouczeniem się.

Vladimir:

Ciekawy jestem Twojej opinii o drugim przykładzie – komputerze IBM Watson i grze Jeopardy (którego polskim odpowiednikiem był Va banque). Co się stało w lutym 2011 i dlaczego ten przykład jest tak słynny. Co zmieniło się po tej grze?

Również ciekawy jestem czy w IBM Watson był bardziej inteligentny byt czy nadal moc obliczeniowa.

Piotr:

Jak najbardziej już inteligentny byt. Deep Blue możemy oczywiście podciągać pod obszary sztucznej inteligencji, logiki i tak dalej i tak dalej. Wybacz że to powiem, ale zakładam coś takiego w informatyce, że jeżeli znasz historię informatyki, bo miałem kiedyś prowadzony taki przedmiot, gdzie zaczynasz rozumieć informatykę i pamiętasz informatykę od poziomu krosno Jacquarda (maszyna żakardowa), jak implementowały się pewne algorytmy, jak budowało się roboty, to nagle dochodzisz do wniosku, że to co się dzieje teraz – to jest coś, co już kiedyś wymyślono, teraz następują tylko i wyłącznie implementacje tego co już było.

Na początku naszej rozmowy zwróciłeś uwagę na to, że algorytmy dotyczące sieci neuronowych, przynajmniej podstawa matematyczna sieci neuronowych to jest stara rzecz, to nie jest nic nowego. To są rzeczy wymyślone w latach 50-ych jeżeli nie wcześniej XX wieku w dodatek. Natomiast teraz mamy możliwości technologiczne, które umożliwiają implementację tych rozwiązań na szeroką skalę. I to nie dotyczy tylko sztucznej inteligencji, to dotyczy komputerów kwantowych, dotyczy praktycznie każdej dziedziny wiedzy, której się dotkniemy, która została w sposób matematyczny zbudowana 100-150 czy 200 lat temu.

To jest pasjonujące moim zdaniem, że w chwili obecnej mamy techniczne możliwości do implementacji rozwiązań które były dawno temu wymyślone. To jest coś co nakręca zarówno przemysł technologiczny, rozwiązania, pomysły na biznes, te całe historie dotyczące pewnych zjawisk, które zmieniają realnie branże. I w pewien sposób Watson jest następstwem tych wszystkich zdarzeń. Dlatego że przez ostatnie 20 lat od czasu Deep Blue, wiedza na temat budowania i sposobów budowania optymalnych baz danych i optymalizowania baz danych poszła niesamowicie do przodu. Przetwarzanie tekstu naturalnego, nazwijmy to natural language processing, poszło niesamowicie do przodu. Udało się zaimplementować algorytmy samouczące, bazujące między innymi na sieciach neuronowych. Skomasowanie tych wszystkich cech, umożliwiło zbudowanie systemu, który ma cechy sztucznej inteligencji, dlatego że rozumie dane, jest w stanie na ich podstawie stawiać pewne tezy, te tezy popierać dowodami, oceniać dowody versus tezy z pewną trafnością i dowodzić pewnych pojęć. I to jest sztuczna inteligencja.

Vladimir:

Na początku, gdy zacząłem nagrywać swój podcast, robiłem wprowadzenie do sztucznej inteligencji. Wtedy powiedziałem że zbiegły się razem trzy czynniki czyli dane, algorytmy i moc obliczeniowa. Dzięki czemu teraz uczenie maszynowe jest tak napędzane. Ciekawy jestem Twojej opinii i czy mógłbyś wyróżnić któryś z tych czynników albo dodać coś.

Piotr:

Myślę że podsumowałeś to idealnie. Duże próbki danych dostępne w jednym centralnym miejscu, dostępne dla konkretnego systemu komputerowego niezależnie jak duży on jest. Druga rzecz – moc obliczeniowa, która jest w stanie równolegle przetwarzać dane, wnioskować na nich i ten proces powtarzać i udoskonalać. Trzecia rzecz, o której wspomniałeś, to algorytmy, które dzięki tej mocy obliczeniowej dużej próbce danych mogły być zaimplementowane i sprawdzone na dużej skali.

Miałem rozmowę, dotyczącą trenowania jednego z dosyć ciekawych komponentów, które udostępniamy jako IBM przez naszą chmurę o nazwie Bluemix czyli Watson visual recognition, komponent który umożliwia rozpoznanie i wyszukiwanie obiektów na zdjęciach bądź trenowanie tego systemu w oparciu o własne próbki zdjęć. Zgłosiła się do mnie firma, która mówi, że “trenujemy komponent na bazie 150 zdjęć, jest super, ale jeszcze trzeba by było udoskonalić znajdowanie tego, tego i tego”.

https://www.youtube.com/watch?v=-s5EpR0eRXY

Popatrzyłem na sposób w jaki oni ten komponent trenują, jak wygląda model, czego poszukują i mówię że “musicie trenować ten model na bazie 1000 czy 2000 zdjęć, wówczas trenujecie go z dobrą dokładnością, a nie na bazie 150 stosunkowo prostych do rozpoznania obiektów”. I właśnie dzięki temu że mamy możliwości zebrania takich ilości danych w bardzo krótkim czasie, mamy algorytmy zaimplementowane i mamy pod spodem dużą moc obliczeniową, możemy to fizycznie robić.

Myślę że kolejnym krokiem w ewolucji tych rozwiązań, zwłaszcza po stronie nie tylko firm które nad tym pracują i dostarczają te rozwiązania, ale zwłaszcza po stronie ich końcowych odbiorców, jest to w jaki sposób możńa konsumować sztuczną inteligencję chmurą obliczeniową. To będzie pisanie aplikacji bazujących na nowym paradygmacie czyli oderwanie programistów, po pierwsze, od infrastruktury i ograniczeń związanych z jej skalowalnością.

Czyli idealna aplikacja wykorzystująca zarówno cechy chmury i sztucznej inteligencji będzie aplikacją która będzie mogła skalować się od zera do nieskończoności, czyli praktycznie obsłużyć dowolny ruch, który do niej przychodzi, bazując na oderwaniu się od infrastruktury. Czyli nowy paradygmat pisania i tworzenia aplikacji, które wykorzystują mikroserwisy, wykorzystują platformy chmurowe, które są pod nimi zapewniając moc obliczeniową.

Programista już nie powinien więcej myśleć o tym, że ma ograniczenie do dwóch, trzech, czterech procesorów w jakiejś maszynie w obszarze jakiegoś klastra obliczeniowego. Nie, on powinien powiedzieć co chce zrobić, jakie obiekty chce powołać do życia i to już kompletnie inna warstwa powinna mu to zapewnić. To będzie kolejny duży krok na przód.

Vladimir:

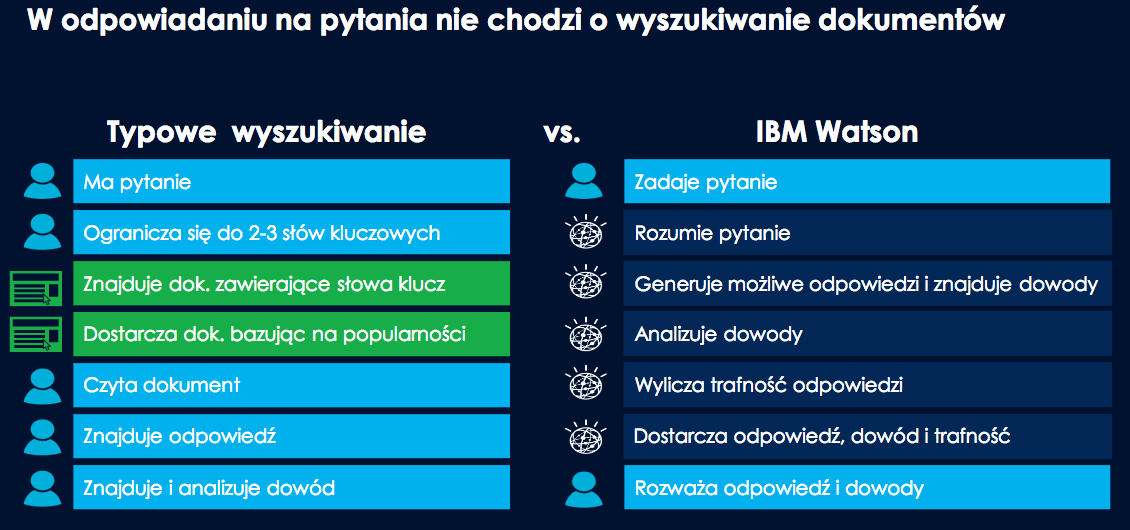

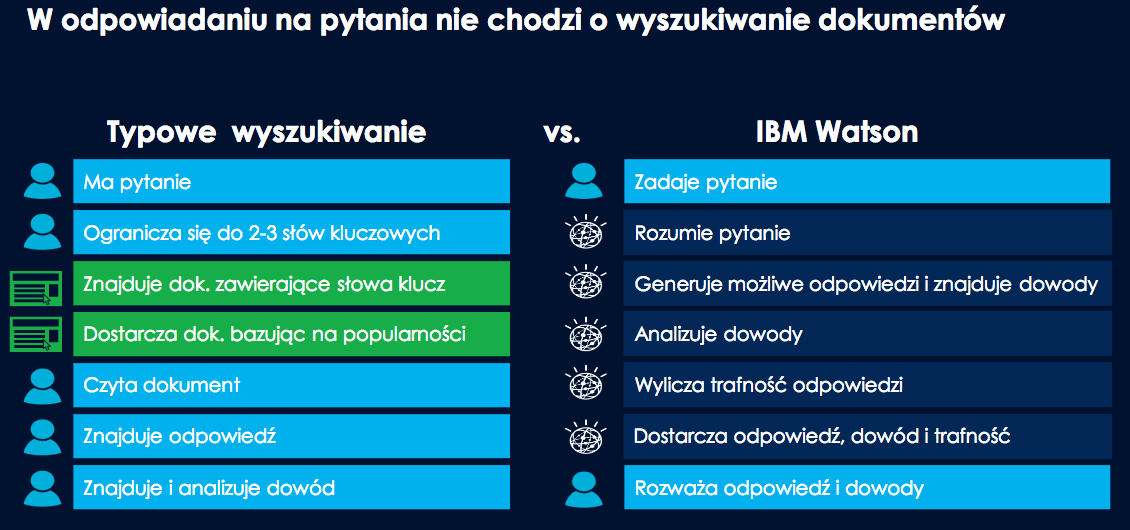

Wróćmy jeszcze do przykładu z IBM Watson, kiedy była gra. Pytanie jest nieco dziwne, ale zapytam, bo pewnie wiele osób myli się, myśląc, że IBM Watson jest wyszukiwarką, która szybko wyszukuje informacje w dużej ilości dokumentów, powiedzmy całej Wikipedii czy innych źródłach wiedzy. Jaka jest różnica pomiędzy wyszukiwarką i IBM Watson, mam na myśli tę implementacje, która wygrała w Jeopardy.

Piotr:

Pierwszą podstawową różnica jest to, że nie bazujemy na czymś co się nazywa keyword. Jest zbudowany cały potok przetwarzania w Watsonie, który mówi w jaki sposób działamy z informacją. Dla nas najważniejsze jest to, żeby użytkownik, po pierwsze, mógł zadać to pytanie i żebyśmy nie szukali dokumentu bazując na tym w jaki sposób i ile słów kluczowych w nim występuje, jak wysoko były oceniane. Tylko żeby w modelu wytrenowanym do rozumienia danego języka czy zbioru wiedzy bazującego na semantyce i ontologii, módz wyłuskać informacje które są potrzebne i przedstawić je użytkownikowi.

Czyli każda wyszukiwarka z którą najczęściej się spotykamy, wyszukuję konkretny dokument i mówi: “Drogi użytkowniku, tu masz listę dokumentów”, tworzy listę rankingową i wyświetla ją w kolejności. W Watsonie to działa kompletnie inaczej. Watson nie koncentruję się na wynalezieniu konkretnego dokumentu, Watson chcę znaleźć odpowiedź na zadane pytanie poprzez rozkład semantyczny tego pytania, zmapowanie go na swoją bazę wiedzy i model, następnie wyłuskać odpowiedź, która wskazuję na to pytanie i podeprzeć ją dokumentami dzięki którym podaje tę odpowiedź z pewna trafnością.

Możemy sobie założyć, że w momencie kiedy Watson przetwarza informację, w pewnym momencie buduje jakiś zestaw odpowiedzi, gdzie każda z tych odpowiedzi posiada jakiś indeks poprawności czy pewności, z którą ta odpowiedź jest udzielana. I Watson pokazuje nam te odpowiedzi, pokazując również ten poziom trafności z którym on twierdzi że odpowiada.

To może być 60% czy 80%, to może być 99,9%. I następnie w modelu trenowania Watsona musi być ekspert, który powie: “ok, ta odpowiedź jest dobra”. Ten sposób rozumowania, dojścia do tej odpowiedzi, ten flow i dokumenty, czyli fakty, które wskazują na udzielenie tej informacji są poprawne. W momencie kiedy nie zgadzamy się z podsumowaniem czy odpowiedzią udzieloną przez Watsona wówczas modyfikujemy zestaw dokumentów który wpłynęły na jego rozumowanie.

I w ten sposób z jednej strony modyfikujemy model wnioskowania, z drugiej – zmieniamy dokumenty, które wpływają na sposób jego trenowania. Czyli do trenowania modelu zawsze jest potrzebny ekspert, to jest pierwsze podstawowe założenie, a druga rzecz taka, że ekspert ma możliwość zmiany sposobu rozumowania systemu. To jest główna różnica między Watsonem czy systemem kognitywnym i podstawową wyszukiwarką bazującą nadal w dużej mierze na keywords’ach, statystyce, popularności.

Vladimir:

Na dzień dzisiejszy IBM Watson ma wiele zastosowań w różnych branżach, takie jak Connie która pracuje jako concierge w hotelu Hilton albo ROSS – robo-prawnik zatrudniony przez kancelarie Baker & Hostetler. Proszę podaj swoje trzy a może pięć przykładów, gdzie IBM Watson został użyty i daje korzyści z punktu widzenia biznesowego (np. możesz podać po przykłady z branży).

Piotr:

Po pierwsze, musimy zrozumieć jak podzielone są te rozwiązania w Watsonie. Część rozwiązań bazujących na technologiach dookoła Watsona są to rozwiązania dedykowane do danej branży. Nie chcę powiedzieć, że są monolitycznymi rozwiązaniami, ale są rozwiązaniami dedykującymi pewne konkretne problemy.

Drugi obszar rozwiązań, to są moduły, nazwijmy to API. To są interfejsy które umożliwiają programistom zasilenie systemu w dane, przetwarzanie tych danych i otrzymanie pewnych rezultatów. To działa w obszarze rozwiązania chmurowego o nazwie IBM Bluemix i nazywa się Watson Services on Bluemix. Tam są dostępne rozwiązania dotyczące przetwarzania tekstu, przetwarzanie mowy, przetwarzanie obrazów, przetwarzanie dokumentów, konwersji dokumentów i wiele innych.

Jest trzeci obszar, który często jest nazywany Watson’om. Też to mogą być składowe komponenty które wchodzą w skład do innych rozwiązań. To jest oprogramowanie które możemy zainstalować na infrastrukturze klienta, możemy budować docelowe rozwiązanie. To są takie rzeczy jak Watson Explorer, narzędzie statystyczne pochodzące z rodziny SPS, narzędzie do rozwiązywania problemów optymalizacyjnych.

Czwartą grupą stanowią, nie chcę powiedzieć – gadżety, ale stanowią przykłady rozwiązań, tak jak przytoczyłeś na przykład concierge, które sa w stanie zwykłym ludziom, którzy nie zajmują się na co dzień technologią i sztuczną inteligencją, pokazać co można za pomocą tych rozwiązań uzyskać.

Jest takie rozwiązanie jak Watson Chef. To jest rozwiązanie, które jest dostępne w internecie i można w popularnych wyszukiwarkach je wyszukać. To jest system, który został stworzony po to, żeby pokazać ludziom w jaki sposób na przykładzie kuchni i składników różnych potraw można budować potrawy do których normalnie nie są przyzwyczajeni. Czyli, na przykład, jak system komputerowy jest w stanie zasugerować człowiekowi zrobienie czekoladowego burrito, które okazuje się być pyszne, ale nie koniecznie sami byśmy na nie wpadli. W sklepach internetowych dostępne są książki kucharskie, gdzie można znaleźć ponad 60 przepisów wygenerowanych przez Watsona, są dosyć ciekawe, są dość abstrakcyjne, ale przede wszystkim smaczne.

Więc mamy cztery grupy rozwiązań. Mamy rozwiązania dla konkretnych branż, rozwiązania dla branży medycznej, chemicznej, dla branży która zajmuje się rozwojem nowych leków, branży budowlanej. I to są rozwiązania dedykowane. O tych rozwiązaniach, które spotyka końcowy użytkownik jako przykład sztucznej inteligencji czy implementacji tego typu rozwiązań, już powiedzieliśmy.

I jest ta cała część pośrodku, adresowana przez programistów, takich jak ty, ja czy nasi koledzy, którzy w pewnym momencie mogą dojść do wniosku i powiedzieć: “a ja bym chciał, żeby moja aplikacja, na przykład, mogła rozpoznawać obraz albo chciałbym, żeby mogła budować behawioralny obraz człowieka, bazując na tym, co pisze w internecie.” I czy jest to możliwe? Jest. Można to zbudować samemu od podstaw, tracąc dużo czasu i pieniędzy, albo można skorzystać z dostępnej usługi, którą integrujemy do swojej aplikacji. Nie ma ograniczeń.

Vladimir:

Wspomniałeś o IBM API. Specajlnie przed wywiadem sprawdziłem, w tej chwilę jest dostępne 19 usług. Większośc z nich jest związane z tekstem, np. jak analiza, rozumienie, tłumaczenie itd. Pierwsze co nasuwa się, jakie języki są wspierany i czy jest plan wspierać polski?

Piotr:

Języki które są wspierane zależą bardzo od usługi. Nie wszystkie usługi wymagają do działania jakiegokolwiek języka. Pomyślmy chociażby o rozpoznaniu obrazów, tam język w ogóle nie jest potrzebny, pomyślijmy o tym w jaki sposób możemy uczyć model predykcyjny, który bazuje na danych pogodowych, tam też nie.

W chwili obecnej w tych usługach, które są dostępne u nas w chmurze które dotyczą języka, język polski nie jest językiem wspieranym. Wspierany jest język angielski, hiszpański, w niektórych z usług jest wspierany język japoński. Implementacja języka polskiego jest w planach. To co możemy robić w chwili obecnej dookoła języka polskiego jest zgromadzenie dookoła tych trzech innych typów rozwiązań. Rozwiązań, które możemy zbudować na życzenie klienta u niego, bazując na tym oprogramowaniu, o którym wcześniej wspominałem, bądź też w obszarze gadżetowym “szytym na miarę”. Natomiast z punktu widzenia dostępnych rozwiązań w języku polskim na chmurze Bluemix, w chwili obecnej nie są dostępne.

Vladimir:

Ciekawy jestem na ile taki zwykły programista, który zdecyduje się użyć IBM API, jest w stanie zbudować odpowiednik, żeby wygrać w Jeopardy. Czy na tym poziomie już możemy operować, czy są ograniczenia, jak na przykład mocy obliczeniowej?

Piotr:

To jest na pewno ograniczenie mocy obliczeniowej, z drugiej strony – zakresu danych, które posiadamy. Przygotowanie Watsona żeby wygrał w Jeopardy trwało prawie rok. System w trakcie gry był odłączony od internetu, czyli nie był zasilany z zewnętrznych źródeł danych poza tymi które zostały do niego wciśnięte.

Kolejna ciekawa rzecz którą można powiedzieć o tej rozgrywce w Jeopardy jest taka, że system komputerowy miał podawane pytania wówczas w wersji tekstowej. Czyli to co czytał zapowiadający, w momencie kiedy skończył, system komputerowy otrzymywał w formie tekstowej i taką treść przedstawiał w drugą stronę, nastąpiła oczywiście detalizacja mowy. Jest dość sporo ciekawych filmików między innymi na YouTube z tego wydarzenia, gdzie Watson jest pokazany troszeczkę od kuchni.

Pokazane są algorytmy, które pokazywały i badały pewność i trafność udzielanej odpowiedzi, które modyfikowały to. Bardzo serdecznie zachęcam do zapoznania się z tym. Sukces Watsona, który wygrywał w Jeopardy w 2011 roku, zachęcił IBM do stworzenia całego pionu biznesowego o nazwie Watson i uruchomieniu produktów oraz całej grupy rozwiązań bazujących na projektach badawczo-rozwojowych, które pojawiły się przy okazji tej gry.

Vladimir:

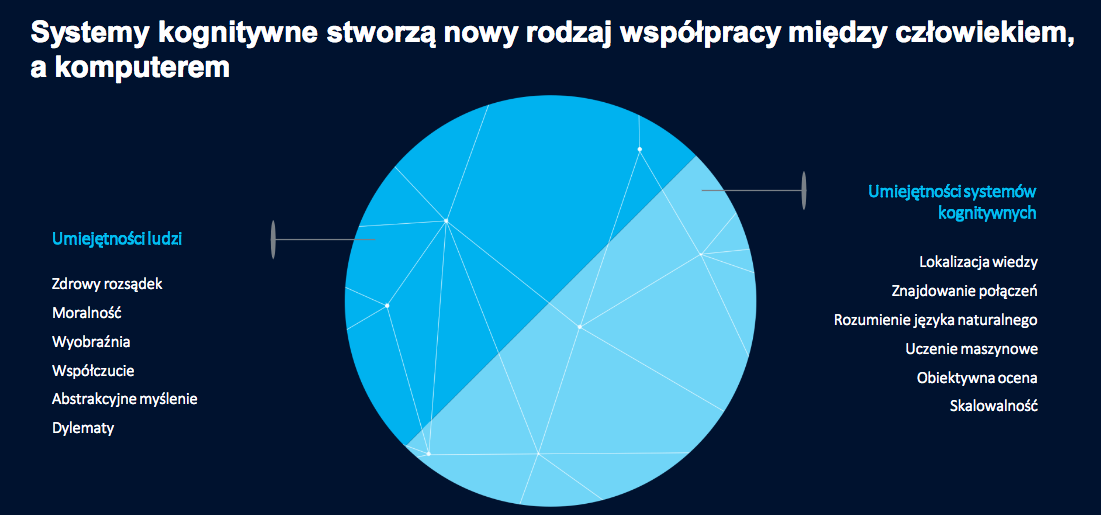

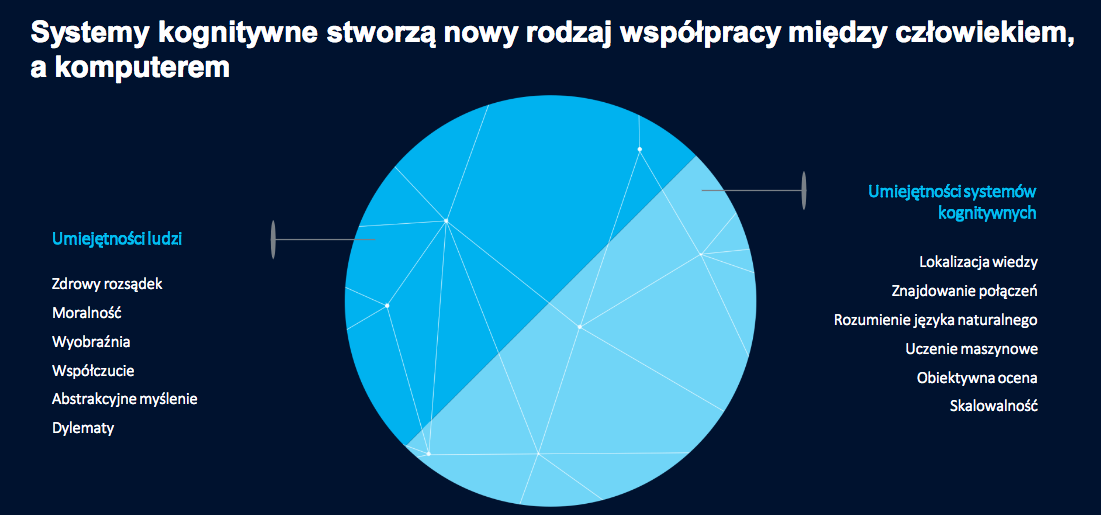

Na jednej Twojej prezentacji, miałeś slajd który był podzielony na dwie części, z lewej strony było to co człowiek potrafi najlepiej takie jak. zdrowy rozsądek, wyobraźnia, moralność, współczucie, abstrakcyjne myślenie, dylematy ), po prawej stronie to co maszyna potrafi najlepiej, a mianowicie: lokalizacja wiedzy, znajdowanie połączeń, rozumienie języka naturalnego, uczenia mszynowe, obiektywna ocena, skalowalność. Tytuł slajdu brzmiał “Systemy kognitywne stworzą nowy rodzaj współpracy między człowiekiem,a komputerem”. Podziel się swoją opinią, jak taka współpraca może wyglądać i tak naprawdę do czego to dąży?

Piotr:

Systemy które jesteśmy w stanie w tej chwili budować, dzięki cechom które przytoczyłeś, dają nam możliwość obserwowania bardzo objektywnego zjawiska. Dane pomagają je interpretować nie wnosząc w nie czynnika ludzkiego. I to moim zdaniem jest niesamowita wartość, dlatego że te systemy nigdy się nie męczą, są zawsze obiektywne, zawsze wskazują decyzje właściwą, która nie niesie ze sobą całego bagażu człowieka. Dopiero człowiek bazując na tej, nazwijmy to, suchej opinii może podjąć końcową decyzje. Wydaje mi się rozdzielenie tych dwóch obszarów w pewien sposób pozwala zachować dobry balans między trafnością, a konsekwencjami późniejszych następstw podjętych decyzji. I to są dwie niezależne drogi.

Oczywiście ten slajd ma pokazywać to rozdzielenie celowo, dlatego że dość dużo osób utożsamia rozwój sztucznej inteligencji, bo wierzy że jesteśmy na początku drogi, z filmami zagłady, science fiction. I to jest myślenie, wydaje mi się, które powinno nie mieć miejsca. Myślenie pod tytułem “mam młotek w sklepie, i ten młotek jest bardzo groźny”. Nie. Młotek nie jest narzędziem groźnym, młotek stworzony po to żeby wykonywać konkretną pracę. Do czego zostanie zastosowany – to już kwestia człowieka. I ten slajd pokazuje to rozdzielenie, czyli sztuczna inteligencja jest pewnego rodzaju młotkiem. Młotek uderzy z odpowiednią siła przyłożoną, wbije ten gwóźdź w miejsce które przyłożymy, pozwoli zbudować wiele różnych ciekawych rozwiązań. Ale również jeżeli przełożymy do niego cechy z prawej strony slajdu, całą ludzką otoczkę, to może nas doprowadzić do zaskakujących, często niepożądanych rzeczy.

Rozdzielenie tych dwóch obszarów ma głęboki sens, dlatego że bazując na twardych danych jesteśmy w stanie podejmować lepsze decyzje już okraszone całością tego co możemy uznać za człowieczeństwo.

Vladimir:

My jako ludzkość w najbliższym czasie będziemy stać przed dużym wyzwaniem, jak zarządzać ryzykiem kiedy maszyna podejmuje pewną decyzje, kto tak naprawdę będzie winny jeżeli ta decyzja była złą. To co usłyszałem w twojej wypowiedzi, brzmi że człowiek może być ostatnim elementem, który będzie nieco minimalizować to. Czy dobrze to usłyszałem czy miałeś coś innego na myśli?

Piotr:

Troszeczkę coś innego, bo patrzę przez pryzmat technologii jako coś co daje nam nowe możliwości. Czy systemy komputerowe podejmują za człowieka decyzje? Oczywiście że tak. Jeżeli jedziemy samochodem i naciskamy przycisk hamulca, to system ABS, który jest niczym innym jak fragmentem oprogramowania w układzie elektronicznym, decyduje z jaką siłą i kiedy hamujemy. Człowiek nie ma na to wpływu, człowiek tylko uruchamia go, żeby zahamować. Został stworzony do tego żeby pomóc człowiekowi ominąć błędy i ograniczenia jego samego.

I nikt się nie zastanawia w chwili obecnej nad tym, czy systemy ABS w samochodach są potrzebne. One tam fizycznie są – wysoko wyspecjalizowane systemy.

Mamy systemy autonomicznego czy automatycznego parkowania w samochodzie, również w standardowych modelach. Jeżeli naciskam przycisk parkowania i proszę komputer, a tak naprawdę kod oprogramowania, współdziałający i zarządzający jakimiś procesami, to czy człowiek decyduje jak ten komputer będzie parkował, no i na koniec dnia bierze za to odpowiedzialność. Ale ten komputer w wielu przypadkach już teraz zaparkuje dużo lepiej, dużo szybciej, dużo sprawniej niż człowiek.

I teraz jest pytanie czy te technologie się upowszechniają i upowszechnią? Tak, i my nawet nie zauważymy kiedy. Dlatego że one dla nas będą coraz bardziej normalne i oczywiste. Również dlatego, że absorpcja tych technologii będzie postępowała w ramach tego, jak perfekcyjne zaczynają się stawać.

Często przytaczam taki przykład z zestawem głośnomówiącym w samochodzie. Wiele osób nie używa interfejsu głosowego w komórce do wybierania numerów, do sprawdzania maila, do dyktowania treści smsa. Dlatego że 20 czy 10 czy 5 lat temu zetknęli się po raz pierwszy z rozwiązaniami które nie działały w sposób dla nich intuicyjny. W chwili obecnej nawet nie próbują ich użyć, bo 5 czy 10 lat temu użyli tych rozwiązań i one nie działały, więc w głowie ekstrapolują że one nadal nie będą działały tak jak oni chcą.

Drugi obszar jest taki, że jako pokolenie które wyrośliśmy przy komputerze z którym bardzo często komunikujemy się przy pomocy klawiatury, to że klawiatura jest naturalnym interfejsem. Nie, klawiatura nie jest naturalnym interfejsem interakcji z systemem komputerowym. Człowiek z systemem komputerem powinien wchodzić w interakcje, tak jak z innym człowiekiem. I w momencie kiedy te bariery zostaną zatarte, będziemy mogli powiedzieć że zaczynamy z takich rozwiązań w pełni korzystać.

Trend, który widać dookoła urządzeń, które mamy w domu, do których możemy mówić, które mogą na polecenie głosowe włączyć światło, sprawdzić pogodę, ustawić ulubioną muzykę, zapytać co słychać, te urządzenia otwierają nas na interakcję z technologią w normalny sposób. I teraz różnica jest taka, że rzeczy które były możliwe na filmach science fiction, robionych w latach 60., w chwili obecnej zaczynają być możliwe na co dzień.

Pamiętam mojego dziadka, który fascynował się Star Trekiem z lat 60., gdzie kapitan Picard mówił do znaczka w klapie i się komunikował. W chwili obecnej jak nie mam komórki w swoim zasięgu, to rozmowę telefoniczną mogę odebrać na komputerze albo na zegarku i rozmawiać przez zegarek. Przeszliśmy olbrzymią drogę i to co nas ogranicza to przyzwyczajenia ludzkie do tego co robiliśmy 5, 10 lat temu.

Zobaczmy co się dzieje w samochodach, które są powszechnie dostępne i używane. Coraz więcej powierzchni, takich które służą do operowania i zarządzania funkcjami, przechodzi w obszar materiałów elektroprzewodzących czy elektro obojętnych, gdzie na koniec dnia cieszymy się z tego rozwiązania, bo wygląda ono nowocześnie, ale z drugiej strony obniża nam koszty produkcji.

Wyobraźcie sobie że schowek samochodowy, który można dotknąć i on się otworzy, jest dużo tańszy w produkcji i serwisowaniu, niż schowek samochodowy złożony z 10-12 elementów, z których każdy osobno trzeba zawieźć i przetestować. Wchodzimy w pewną erę technologiczną w której rozwiązania, o których kiedyś oglądaliśmy filmy, są już możliwe do implementacji, ale z drugiej strony nasze przyzwyczajenia ograniczyły nas, jako zwykłego użytkownika (nie mówię o technologicznych geekach).

Vladimir:

Poruszyłeś bardzo ciekawy temat interfejsu pomiędzy człowiekiem a komputerem, a właśnie przez to, że używając klawiatury, bardzo wolno przekazujemy dane do komputera. I chciałbym zapytać o twojej opinii o Elonie Musku, a bardziej o firmie którą założył pod nazwą Neurolink. I on ma taki pomysł żeby zintegrować komputer czy maszynę z mózgiem. Wspomniałeś, że w pewnym sensie komórka, jako przykład czegoś mądrego w naszej ręce, jest częścią naszego ciała. Natomiast nie ma, przynajmniej publicznie udostępnionych, integracji pomiędzy komputerem a mózgiem. Co o tym myślisz i kiedy twoim zdaniem to będzie możliwe?

https://www.youtube.com/watch?v=y6rqNLDnO94

Piotr:

Myślę że to będzie możliwe szybciej niż nam się to wydaje, dlatego że takie rozwiązania powstają już od wielu lat. Nazwijmy to rozwiązania, które bazując na pewnych odkryciach i cechach zachowań fal mózgowych i naszych reakcjach elektrycznych w mózgu, chociażby w trakcie badania EEG, pozwalają sterować obiektami, przesuwać je. I tego typu rozwiązania już istnieją. Od tego teoretycznie jest bardzo krótka droga do wykonywania bardziej skomplikowanych czynności.

Co jest ciekawe w tych rozwiązaniach? To to, że korzystają z nanotechnologii. To będzie kolejny olbrzymi trend, jeżeli chodzi o wearable devices czyli wszelkiego rodzaju urządzenia, które nosimy na sobie, a za chwile będziemy nosić w sobie lub na sobie, ale w zupełnie innej postaci. Zauważmy, że coś co się zaczęło od różnego rodzaju gadżetów fitnessowych w chwili obecnej przeradza się w trend bardzo związany ze zdalną opieką i diagnostyką medyczną.

Obserwujemy,że jeżeli chodzi o miniaturyzację wszelkiego rodzaju czujników, a wraz z miniaturyzacją i zwiększaniem się mocy obliczeniowej w pojedynczym układzie tranzystorowym, możliwa jest wstępna analiza danych już na poziomie samego urządzenia. Są bardzo mocno zaawansowane prace nad soczewkami, które pozwalają wyświetlać rzeczywistość rozszerzoną.

Pamiętam, jak zaczynałem swoją pracę w IBM, firma Polcont prowadziła konferencje w Polsce dotyczącą nowych technologii i już ponad 10 lat temu pokazywaliśmy tam ekrany HUD dla żołnierza przyszłości. W chwili obecnej w różnych firmach trwają prace nad tym, żeby ekrany HUD integrować z soczewką wkładaną do oka, więc postęp w tej dziedzinie jest niesamowity.

Pytanie jest tylko takie, czy jesteśmy w stanie znależć realna wartość biznesową czy realną wartość dla naszego życia codziennego, płynącą z takich rozwiązań. I to jest bardzo często dyskusyjne, bo wiele rzeczy da się zrobić nawet w sposób optymalny kosztowo, a druga rzecz – pokazać użytkownikom że oni tego tak naprawde potrzebują.

Vladimir:

Nas słuchają osoby decyzyjne, ludzie z biznesu, które chcą zacząć używać uczenie maszynowe w praktyce. Jakie praktyczne rady możesz im dać, na co należy zwracać szczególną uwagę? Jak użyć uczenia maszynowego w sposób optymalny?

Piotr:

Możno podejść do tego na dwa sposoby. Pierwszy sposób – to korzystać z usług partnerów, którzy już coś zrobili, gdzieś zaimplementowali i mogą to pokazać. Może to być zrobione w obszarze naszej branży, tego co nasza firma robi. A z drugiej strony, jeżeli naprawdę chcemy zmieniać pewnego rodzaju branżę i budować swoją przewagę konkurencyjną, to musimy mieć pewnego rodzaju zwiększoną chęć do ponoszenia ryzyka.

Pamiętajmy, że wszelkiego rodzaju nowe technologie i rozwiązania, nawet jeżeli wygląda na to, że biznes kejsy wychodzą pozytywnie, niosą ze sobą odpowiednie ryzyko, że założone cele mogą się nie sprawdzić albo nie zadziałać. Dlatego zachęcam przede wszystkim do budowania prototypów, do sprawdzania koncepcji, do tego żeby nie brnąć w olbrzymie monolityczne projekty, które mają być realizowane przez rok, dwa, trzy. Tylko podchodzić do nich w taki sposób, żeby wymyślać w jakim obszarze może być wniesiona wartość, sprawdzić czy ta wartość ma szansę być wniesiona, a następnie podjąć ryzyko jej implementacji. Bo to jest jedyny sposób na wyprzedzenie konkurencji naszej branży.

Jeżeli będziemy bezczynnie czekali tylko i wyłącznie na to, żeby współpracować i budować rozwiązania, które ktoś już zaimplementował na rynku i z sukcesem, to znaczy że nigdy nie będziemy tymi, którzy na tym rynku będą wygrywali dzięki technologii. Zawsze będziemy podążającym za kimś i być może z czasem zrobimy to rozwiązanie nawet lepiej niż nasza konkurencja, ale nadal to nie my będziemy tymi innowacyjnymi, zmieniającymi oblicze branży i o których będa mówili na prezentacjach.

W momencie kiedy mamy do czynienia z nowymi pomysłami i technologiami, musimy zaakceptować pewnego rodzaju ryzyko, chyba że przenosimy dokładnie jeden do jednego rozwiązanie, które już przez kogoś zostało zaimplementowane.

Vladimir:

Jeżeli chcemy być liderami, nie możemy się bać, a tylko eksperymentować. Natomiast musi być zdrowy rozsądek. Muszą to być bardzo tanie eksperymenty, szybka informacja zwrotna, ale jeżeli nam na tym nie zależy zawsze będziemy krok do tyłu.

Piotr:

Tak i osoby które do tej pory nie spotkały się z metodykami zwinnymi prowadzenia projektów i mają bardzo często problem z akceptacją tego bądź definicją tego, co może być uznane za proof of technology czy proof of concept. I bardzo często dążą do tego, żeby swoją wizje świata idealnego przenosić na wymagania na proof of concept. I to się nigdy nie sprawdzi.

Pamiętam jak w Polsce zaczynał kiełkować trend Cloud Computingu czy usług chmurowych. Wiele firm postanowiło że chcą mieć takie infrastruktury, zbudowane u siebie. Zaczęło budować specyfikacje tego co chcą, specyfikacje które wysyłali do dostawców opisywały rozwiązania, które może zaistnieją na rynku za 5-6 lat, firmom którzy w tym się specjalizują. I taki sposób nigdy nie zadziała.

Vladimir:

Powiedziałeś kiedyś, że “Kluczową kompetencją staje się zdolność adaptacji do przemian oraz wykorzystania trendów.” Z jednej strony nic nowego, bo w biznesie zawsze chodziło o zmiany. Wydaje się, że jednak w Twojej frazie jest głębszy sens. Człowiek zdecydowanie wolnej adaptuje się do zmian, niż technologia. Przez technologie zmiany będą napędzane jeszcze szybciej. Proszę podziel się swoją opinią na ten temat… I dokąd to wszystko pędzi? Gdzie będziemy za 20 czy nawet 10 lat?

Piotr:

Pierwsza rzecz jest taka, że największym stoperem rozwoju technologii i implementacji technologii na koniec dnia, są ludzie, nasze obawy i brak otwartości.

Wyobraźmy sobie bardzo prosty przykład. Mam sieć sklepów czy hurtowni (załóżmy na terenie całego kraju), chcę zwiększyć profitowość sprzedaży, chcę obniżyć koszty magazynowania, chce zoptymalizować logistykę. Dlaczego nie wykorzystać w modelu planowania, przewidywanie i prognozowanie pogody. Dane które są dostępne, które firmy w wielu miejscach świata używają czy testują. Co nas przed tym powstrzymuje? Wstrzymuje niechęć do podejmowania ryzyka i niechęć do zmiany. Pomimo tego, że podświadomie (w tym przykładzie) wszyscy czują że informacja dwa tygodnie wcześniej o tym, że na przykład w wakacje polskie wybrzeże będzie nie słoneczne i warto tam dostarczyć parasole, powinna być zautomatyzowana. Dlatego że wtedy siadają koszty operacyjne i podnosi się nasza wydajność. Dzięki temu, na przykład w skali sieci sklepów, obniżają się koszty logistyki, podnosi się marżowość produktu, podnosi się wielkość pojedynczego koszyka.

To jest jeden przykład z życia jakiejś bardzo konkretnej branży, która mogłaby wykorzystać pewnego rodzaju dane pogodowe do usprawnienia swoich wewnętrznych procesów, optymalizacji sprzedaży i zarządzania asortymentem.

W którą stronę to idzie. Dosyć ciekawie to opisują w książce Race Against the Machine profesorowie z MIT. Którzy pokazują tezę taką, że idziemy w stronę świata w którym w pewnym momencie będziemy musieli ludziom płacić za nie robienie niczego. Nastąpi taki poziom automatyzacji, taki poziom zastąpienia ludzi, że albo całe branże i całe grupy zawodowe będą się transformowały, albo będą powstawały grupy zawodowe ,którym trzeba będzie płacić wynagrodzenie za nie robienie niczego. I to jest bardzo ciekawie opisane w książce Race Against the Machine którą bardzo serdecznie polecam.

Na pewno stoimy w perspektywie czasu przed wyzwaniami nie stricte technologicznymi, ale przed wyzwaniami stricte socjologicznymi i to pewnie będzie obszar do zagospodarowania przez wielu badaczy i wiele firm.

Trochę powtarzamy czasy rewolucji przemysłowej. Pamiętajmy, że historia lubi się powtarzać, tak jak przeszliśmy z epoki kamienia w epokę koła, później przez wiele innych etapów do rewolucji przemysłowej, która też miała wiele zmienić. Weszły maszyne parowe, które też zmieniły sposób w jaki ludzie pracowali i wytwarzali dobra. W chwili obecnej żyjemy w świecie rewolucji bardzo mocno cyfrowej, gdzie zmienił się tylko obszar, który napędza tę rewolucję z pary na dane. Co nam to przyniesie…zobaczymy! Zakładam że samo dobro.

Vladimir:

Czyli jesteś nastawiony optymistycznie…

Piotr:

Bardzo. Inaczej nie byłoby postępu.

Vladimir:

Zapytałem o przyszłość technologiczną, teraz zapytam o przyszłość prywatną. Może zdradzisz trochę o planach które masz, zwłaszcza związane z tematem uczenia maszynowego czy sztucznej inteligencji?

Piotr:

Bardzo trudne pytanie. Na pewno chcę uczestniczyć w jak największej ilości projektów w których uczenie maszynowe przekuwa się na realną wartość dla końcowego klienta.

Na pewno chciałbym uczestniczyć w projektach, które łączą uczenie maszynowe z daleko posuniętą robotyzacją. Bardzo ciekawym obszarem rozwiązań są powstające egzoszkielety, wsparcie ich sztuczną inteligencją, opomiarowanie. To są rzeczy, które mogą przynieść w perspektywie niedalekiego czasu niesamowity postęp, zwłaszcza w obszarze rehabilitacji osób niepełnosprawnych, po wypadkach, przykutych do łóżka. To są rzeczy, które będą zmieniały naszą rzeczywistość i otwierały nowe możliwości przed ludźmi, którzy do tej pory tych możliwości nie mieli. Chciałbym być częścią takich zmian. Traktuje to jako podróż w nieznane, ale jestem gotowy ją odbyć.

Vladimir:

Ostatnie pytanie na dzisiaj. Czy w razie potrzeby słuchacze mogą kontaktować się z Tobą i jeżeli tak, to jak mogą to zrobić? Czy jesteś otwarty na takie kontakty?

Piotr:

Jak najbardziej. Najszybciej można się ze mną skontaktować przez Twitter. Mój nickname po prostu PiotrPietrzak.

Vladimir:

Dziękuję Ci bardzo za twój czas.

Podsumowanie

Rozmowa z Piotrem mogła jeszcze trwać co najmniej godzinę… Jest to człowiek pasji i dość rzadko spotyka się osobę, która pracuje w tak dużej firmie na wysokim stanowisku i jest tak otwarty w rozmowie (również już po nagraniu podcastu). Spędziliśmy jeszcze jakiś czas na omówieniu różnych tematów i wyzwań które są obecnie.

Ciekaw jestem Twojej opinii. Podziel się na itunes zastawiając komentarz, czy na stronie biznesmysli.pl albo na facebook. Będę bardzo za to wdzięczny.

Już dostaję od słuchaczy pytania na różne tematy związane z uczeniem maszynowym. Jeżeli również masz jakieś – to pisz śmiało do mnie, na stronie kontakt znajdziesz formularz. Również, jeżeli zależy Ci bardzo, żebym skupił się nad którymś tematem bardziej, to proszę daj mi tym znać, zbieram takie głosy i to pomaga mi ustalić dalsze priorytety. W najbliższym czasie mam już plan szeregu wywiadów z ciekawymi ludźmi z branży. Z drugiej strony, myślę, że warto robić tematy gdzie skupiam się nad pewnym zagadnieniem, jak to było w kilku pierwszych odcinkach. Co o tym myślisz?

Podziękowania

Tomasz Wóźniak zostawił recenzję na itunes z pięciu gwiazdkami. Dzięki wielkie Tomku :).

Patryk Wójcik również dziękuję Tobie za Twoją aktywność, udzielanie komentarze na blogu, facebook.

Dziękuję również za like, tweety, polubienia – bardzo mi miło, że to co robię ma odzew :).

Ogłoszenia

Zacząłem ten odcinek od konferencji zorganizowanej przez Apple. Jeżeli chcesz posłuchać więcej detali po polsku to polecam odcinek #13, podcastu Szymona Drejewicza – Data Science po polsku. Szymon bardziej skupia się na procesie, również ten podcast może być bardzo ciekawy jeżeli rozważasz zrobić swoją karierę jako “data scientist”.

Miałem okazję być gościem podcastu “Lepiej Teraz” który prowadzi Radosław Budnicki. Jeżeli jeszcze nie słuchałeś tego podcastu – to gorąco polecam. Radek jest coachem na co dzień i ma talent do znajdowania ciekawych i inspirujących ludzi, których zaprasza na rozmowę. Mój wywiad jest w odcinku nr. 59, gdzie między innymi dowiesz się więcej o mnie. Zapraszam do posłuchania podcastu “Lepiej Teraz”.

W sobotę, 17 czerwca odbyła się konferencja dla podcasterów i słuchaczy podcastów – Polcaster 2017. Miałem okazję również opowiedzieć o trudnościach jakie miałem, kiedy zaczynałem Biznes Myśli i jak je pokonywałem.

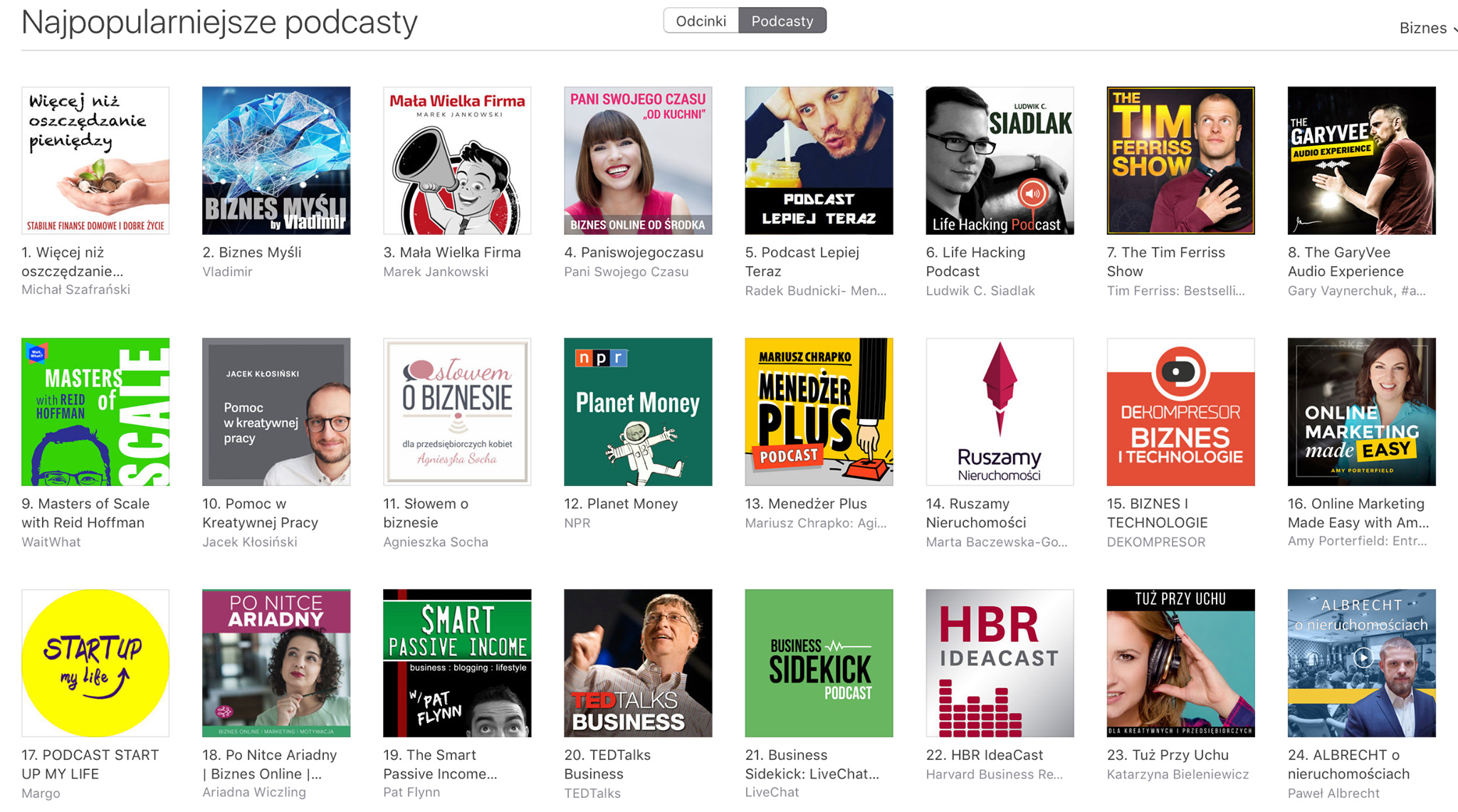

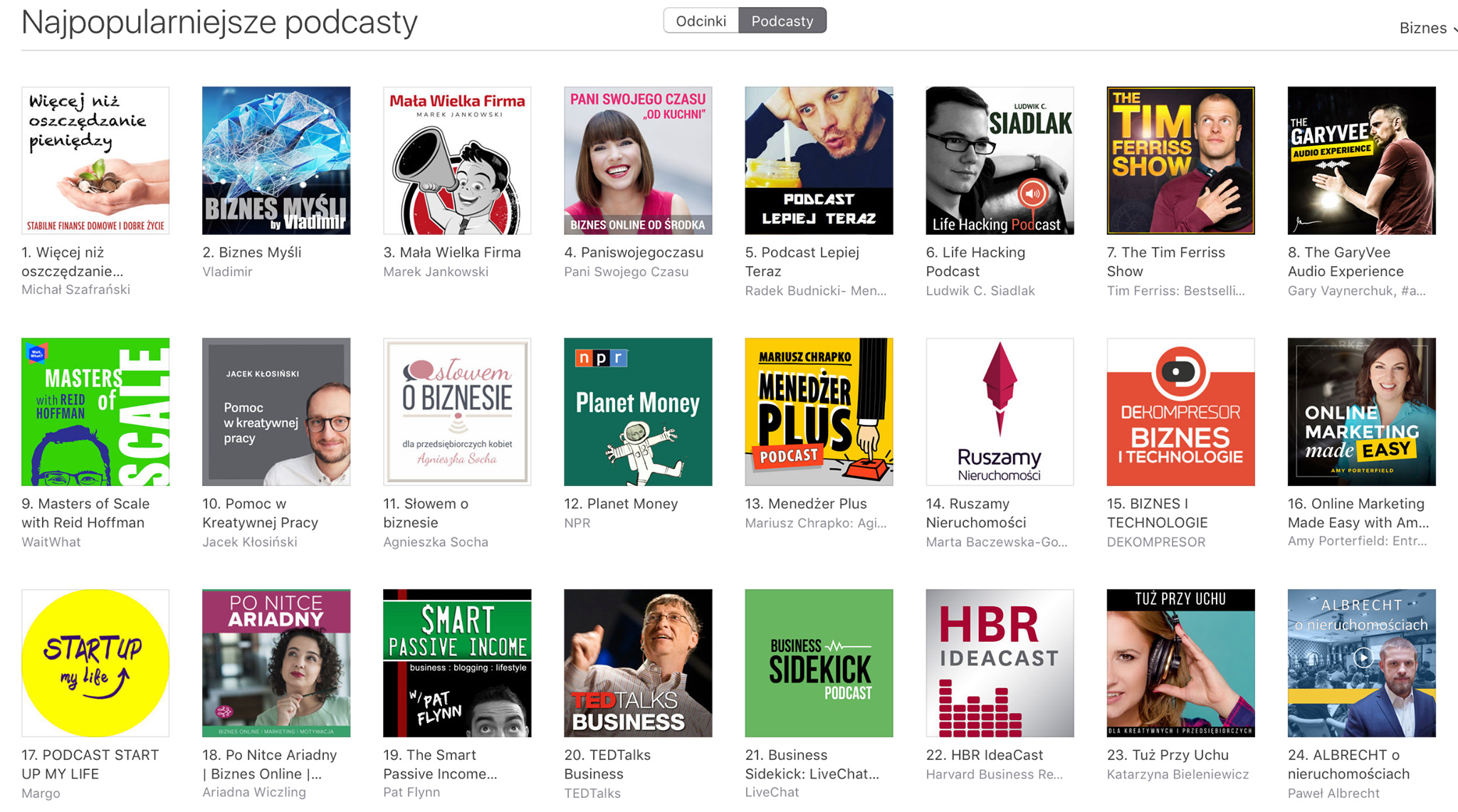

Podcast ma dopiero trzy miesiące i staje się coraz bardziej popularny. Już był w TOP 20 wszystkich podcastów i TOP 2 w kategorii biznes.

To jest super… ale często nie widać jakie trudności są pomiędzy. Wyjścia ze strefy komfortu, wątpliwości i wiele innych emocji. Chciałem opowiedzieć swoją historię i podzielić się tym jak to przeżywałem i radziłem sobie z tymi wyzwaniami. Mało tam jest o moim bohaterstwie, ale dużo o tym jak małymi krokami i wsparciu właściwych osób możesz osiągnąć wszystko co tylko chcesz. Tego bardzo Ci życzę… żeby w Twoim otoczeniu znalazły się osoby które pomogą Ci rozwinąć Twoje skrzydła.

Bardzo polecam obejrzeć to osobam które wychdozą ze strefy komfortu i mają dużo wątpliwości.

27 czerwca, w Krakowie będę miał przyjemność powiedzieć więcej na temat sztucznej inteligencji, a mianowicie o ryzyku i możliwościach które nam daje. Również będzie na VR – wirtualnej rzeczywistości. Jeżeli będziesz w Krakowie w tym czasie, chcesz posłuchać tych tematów a może spotkać się ze mną, to gorąco zapraszam.

To tyle na dzisiaj. Dziękuję za Twój czas, Twoją energię i do usłyszenia w następnym odcinku.