Czy sztuczna inteligencja rozumie co mówisz do niej?

Z tego odcinka dowiesz się:

- dlaczego warto przeczytać „Innowatorów” Isaacsona?

- czym zajmuje się prezes małej firmy?

- czy można połączyć biznes ze światem akademickim?

- czym jest ASR, TTS i biometria głosowa?

- jak działa system automatycznego rozpoznawania polskiej mowy?

- w jaki sposób możemy zamienić tekst na mowę?

- czy można zidentyfikować i zweryfikować mówiącego?

- jak nadążać za zmieniającą się rzeczywistością?

- czy smartfony za 5 lat będą nam w ogóle potrzebne?

- czy jest możliwe zamówienie Ubera, mówiąc do aplikacji?

- dlaczego warto zapisać się na kurs praktycznego uczenia maszynowego na DataWorkshop?

O Google Duplex wspominałem już w poprzednim odcinku, Google IO 2018 przedstawiło wersję demo. Teraz jest już dostępne do testów poza Google dla zaufanych testerów. Co oznacza, że już w najbliższym czasie (w ciągu kilku lat), Google Duplex stanie się bardziej popularny i być może wkrótce zadzwonią do Ciebie.

Opowiem Ci historię o tym jak świat zmienia się naprawdę szybko. Ostatnio odwiedziłem moją wieś (rzadko tam bywam, ostatni raz 4 lata temu), z której wyjechałem 16 lat temu. Wtedy wyjechałem do Mińska, dlatego że byłem pewny, że żadna cywilizacja nie pojawi się na tej wsi (akurat teraz potrzebuję takich cichych zakątków od czasu do czasu), ale… nawet tam wszystko się zmieniło. Działa telefon (również komórkowy), jest internet i moje zdziwienie było ogromne, gdy zobaczyłem, że ludzie rozmawiają z telefonami. Okazało się, że wyszukiwanie w Google czy Yandex jest znacznie trudniejsze, gdy wpisujesz hasło, niż gdy pytasz go wprost i czekasz na odpowiedź. Nawet doszedłem do wniosku, że ludzie z takich miejscowości szybciej adaptują się do personalnych asystentów (jest im też łatwiej uwierzyć w sztuczną inteligencję), niż ludzie z większych miast (bo to też kwestia przyzwyczajenia).

Do czego to prowadzi? Interfejsem do komunikacji z komputerem staje się głos. Dlatego rozumienie głosu staje się coraz ważniejszym zadaniem. Są znane rozwiązania od dużych graczy, ale przez to, że np. Google koncentruje się na wielu językach, to ostatecznie przegrywa z firmą, która koncentruje się tylko na jednym.

Dzisiejszym gościem jest Bartosz Ziółko CEO firmy Techmo. Firma tworzy kilka rozwiązań, jedno z nich to transformacja głosu w tekst, wiem, że to rozwiązanie jest stosowane w kilku większych firmach lub bankach w Polsce, nie będę wymieniać nazw, ale tę informację mam ze sprawdzonych źródeł. Dlaczego zdecydowali się na lokalnego dostawcę? Bo po prostu działa lepiej niż więksi gracze. Chociaż muszę przyznać, że dodatkowo sam Bartek jest bardzo ciekawą i inspirującą osobą. Bardzo fajnie się z nim współpracuje, sprawdziłem to w trakcie przygotowanie się do tego odcinka :).

Zapraszam do wysłuchania.

Cześć Bartek. Przedstaw się, powiedz kim jesteś, czym się zajmujesz, gdzie mieszkasz.

Cześć. Nazywam się Bartek Ziółko. Mieszkam w Krakowie. Zajmuję się rozpoznawaniem mowy i ogólnie przetwarzaniem dźwięku, częściowo jako prezes zarządu i założyciel spółki Techmo, częściowo jako adiunkt AGH.

Co ostatnio czytałeś?

„Innowatorzy” Isaacsona. To jest książka analizująca życiorysy różnych osób, mniej więcej od czasu – powiedzmy – dżentelmeńskiej Anglii, po czasy współczesne i porównująca kto, w jakim stopniu osiągnął sukces, z jakich powodów, nawet niekoniecznie czysto merytorycznych, tylko na przykład kto działał w odosobnieniu, kto działał w jakichś dużych ośrodkach, czym się w życiu kierował, jakie miał cechy charakteru. Dopiero zacząłem, bo niestety, czasu na czytanie dużo nie mam, natomiast analiza jest dość ciekawa i pouczająca.

O, dzięki wielkie! Akurat nie słyszałem o tej książce, a brzmi super. Chyba muszę do niej zajrzeć. Pochodzisz ze środowiska akademickiego, założyłeś firmę Techmo, po wizycie na uniwersytecie Stanforda. No i właśnie, co się stało po tej wizycie? Czy zaszczepili Ci przedsiębiorczość, być może ją obudzili? Opowiedz całą historię.

Powiedziałbym w skrócie, że odważyli mnie. Bo już trochę myśleliśmy o założeniu firmy wcześniej, tylko wydawało nam się to takie skomplikowane, trudne, ryzykowne, a nie było takich – powiedzmy – potrzeb komercjalizacji w naszym zespole na AGH aż tak dużo. Więc tak odkładaliśmy to na później. Jak tam pojechałem, to wtedy było w modzie powiedzenie: „It`s OK to fail” i było bardzo duże nastawienie: „Spróbuj, zobaczysz co będzie”, więc stwierdziłem, jak wróciłem: „Spróbuję i zobaczę, co będzie”. I to był na pewno bardzo dobry krok w moim życiu.

Czy to oznacza, że w Polsce nadal brakuje na uczelniach, w świecie akademickim, takiego podejścia biznesowego? Czy to się zmienia? Jak widzisz to teraz?

To się na pewno zmienia. Natomiast myślę, że trochę jeszcze brakuje. Jest o tyle ciężko, że w praktyce polskie uczelnie, zwłaszcza te duże – czyli de facto, przynajmniej teoretycznie, najlepsze – są bardzo feudalne i to jest środowisko, w którym jest trudno tak naprawdę o realnie twórczą pracę. Wydaje mi się, że stąd są takie dość niskie lokaty najlepszych polskich uczelni w rankingach światowych, dlatego polskie laboratoria nie dostają Nagród Nobla i tak dalej. Są takie warstwy, które są dość trudne do ruszenia i przez to środowisko nie jest odpowiednio dynamiczne.

Łączysz dwa światy: świat akademicki i biznesowy. A powiedz jak wygląda Twój codzienny – o ile mogę tak powiedzieć – dzień pracy?

Tak. To jest bardzo trudne pytanie. Właściwie każdy dzień jest inny. Zawód prezes zarządu małej firmy oznacza, że robisz wszystko, łącznie czasami z wynoszeniem śmieci. Natomiast taka dość typowa rzecz, którą ja robię, to pisanie różnego rodzaju wniosków o badanie, najczęściej do Narodowego Centrum Badań i Rozwoju. Staramy się je dopracować. Zawsze piszemy je sami, nie korzystamy z żadnych zewnętrznych firm, więc na to dość dużo czasu schodzi. Oprócz tego są różne nasze narady wewnętrzne, związane z tym, co i jak robić, czasami kontrola tego, co się w poszczególnych produktach i projektach dzieje, ale tego jest dość mało. Mam to duże szczęście, że mam bardzo dobrych i zgranych wspólników, którzy się tą częścią techniczną tak naprawdę w dużej mierze zajmują. Są rzeczy związane z rekrutacją, są rozmowy z klientami, więc każdy dzień przynosi nowe rozrywki.

A czemu uważasz, że pisanie wniosków do NCBR przez Ciebie może być lepszym rozwiązaniem, niż zlecanie tego? Bo zrobisz to lepiej? Dlaczego tak myślisz?

Na pewno jest to po prostu moja kompetencja. To jest jedna z rzeczy, której nauczyłem się na AGH i jestem w tym dobry, więc chcę z tego korzystać. To jest pierwsza rzecz. Druga rzecz: niestety trzeba powiedzieć, że relatywnie duża część tych firm, które piszą wnioski, jest po prostu nieuczciwa. Znam osobiście przypadki, gdzie były problemy. Teraz jesteśmy na przykład w jednym takim projekcie, gdzie lider konsorcjum korzystał z takiej firmy i to wywołało spore problemy.

No i trzeci powód: mówimy o instytucji, która moim zdaniem jest najlepszą instytucją finansującą badania w Polsce, czyli właśnie o NCBR. Nie jest to oczywiście oficjalnie przez NCBR w żaden sposób publikowane, ale ja non stop odnoszę wrażenie, że oni walczą z tymi firmami. I zresztą uważam, że słusznie. Te programy powinny być na tyle proste, że każdy może sam swój pomysł opisać, a z drugiej strony – wytwarza się trochę taki niebezpieczny świat naciągania. Jeżeli są profesjonaliści, którzy tak naprawdę nie rozumieją części merytorycznej, tylko uczą się, jak pisać wnioski tak, żeby one przeszły, nikt się wtedy nie przejmuje za bardzo częścią merytoryczną. I właśnie dlatego wydaje mi się, że NCBR to na tyle, na ile może, ogranicza. Na przykład teraz jedziemy na panel bronić naszego wniosku. I to już jest oficjalnie w regulaminie, że nie wolno brać ze sobą doradców, konsultantów i tego typu osób, tylko mogą być osoby przewidziane do pracy w projekcie lub inni pracownicy etatowi wnioskującego. Tego się właśnie trzymamy.

Dzięki za Twoje rady. Akurat teraz poznaję coraz więcej osób, które podobnie jak Ty, ubiegają się o wniosek, więc myślę, że było to dla nich ciekawe, usłyszeć poradę od osoby, która również robi podobne rzeczy.

Przechodzimy do dzisiejszego tematu, którym jest rozpoznawanie mowy albo tak zwany ASR (Automatic Speech Recognition). Zaczniemy od definicji. Czym jest ASR?

To jest definicja w miarę samo tłumacząca się, tu nie ma raczej pułapki, więc jest to właśnie symulacja procesów, które robią ludzie, czyli rozpoznawanie mowy. Tu jedyne co trzeba trochę rozróżnić i co czasami ludzie mylą, to rozpoznawanie mowy i jej rozumienie. My się właśnie zajmujemy częścią zamiany głosu na postać cyfrową. To niekoniecznie jest tekst, to są czasami takie bardziej złożone siatki słów. Natomiast oprócz tego jest druga branża, która w sumie jest mniej rozwinięta, więc w tej chwili możliwe, że bardziej atrakcyjna pod kątem jakichś nowych wyzwań i nowych firm, czyli bazowanie na tym, co my już zrobiliśmy i robienie wokół tego scenariuszy. Czyli na przykład rozmowa z naszym potencjalnym klientem sprzed dwóch dni: chcą zrobić automat, który będzie analizował rozmowę i będzie mówił, czy ta rozmowa była udana. Więc to nie jest rozpoznawanie mowy. To jest ten poziom wyżej, to już jest jej rozumienie. I to jest właśnie cały dodatkowy zakres działań.

Dobrze. A czy to oznacza, że poza słowami rozpoznajecie jakieś przecinki, kropki i próbujecie układać to w zdania?

W takich systemach produkcyjnych to raczej zakłada się, że takie rzeczy powinny być dyktowane, że ktoś mówi: przecinek, kropka i tak dalej. Natomiast od strony takiej badawczej, to robiliśmy takie prace, na przykład żeby wyłapywać pauzy albo oddechy, takie różne zająknięcia, które są naturalne w mowie i porównywać ich korelacje z oczekiwanymi miejscami interpunkcji w tekście. Ta korelacja jest, ale ona jest jeszcze na tyle mała, że my tego w takim systemie produkcyjnym na razie nie stosujemy.

Nawiązując do badania. Twoja praca doktorska miała tytuł „Speech Recognition of Highly Inflective Languages”. Ta praca ma 122 strony, więc nie będziemy omawiać jej tutaj w całości, bo zajęłoby to nam cały odcinek, ale powiedz tak w skrócie, o co chodziło w tej pracy. Być może ktoś zainteresuje się tematem od strony teoretycznej. Oczywiście dodam, że link będzie w notatkach.

Tę pracę robiłem 10 lat temu. Więc jak skończyłem ją robić, to był właśnie czas, kiedy wróciłem do Polski, a więc wtedy rozpoznawanie mowy polskiej było w powijakach, w porównaniu do tego co jest teraz. Bardzo mało osób się tym zajmowało i moja praca była w dużej mierze adaptacją różnych elementów, właśnie na potrzeby języka polskiego. Dlatego w tytule jest: języków fleksyjnych, żeby to trochę rozszerzyć i nie narzucać języka polskiego. No ale w praktyce skupiłem się raczej na przykładzie polskim, aczkolwiek pewne wyzwania, które są w rozpoznawaniu mowy polskiej dotyczą wszystkich języków słowiańskich w podobnym stopniu: że jest właśnie odmiana, to nie są języki pozycyjne, jest mniej danych niż w wypadku języka angielskiego. To są takie dość powtarzalne rzeczy.

Porozmawiajmy teraz o firmie Techmo i o Waszych produktach. Tworzycie kilka ciekawych produktów. Najbardziej prawdopodobnie znany i o tym będziemy najwięcej mówić jest: Techmo ASR, również jest system TRYBUN, system SEZAM i SoundToolKit. Trochę tego jest. Zaczniemy od początku. Proszę powiedz przynajmniej kilka słów o każdym produkcie, a potem jeszcze spróbujemy to rozwinąć.

Techmo ASR to jest właśnie nasz system rozpoznawania mowy. Są właściwie trzy produkty, w trzech trybach. Pierwszy, taki najbardziej konwencjonalny, to jest tryb działający według gramatyk SRGS, czyli to jest taka wersja, w której projektant systemów zakłada, co użytkownik może powiedzieć, prostym językiem opracowywuje scenariusz dopuszczalny i nasz system, pracując, zakłada, że było powiedziane jedno z tych zdań lub ewentualnie, czy należy zgłosić komunikat, że jest wysokie prawdopodobieństwo, że było powiedziane coś poza słownikiem. I to jest taki typ działania, który się bardzo sprawdza w wypadku takich zastosowań, powiedzmy, trochę ankietowych, gdzie chcemy odebrać jakąś konkretną daną, na przykład nazwę ulicy. Wtedy zawężamy dość istotnie słownik, więc zwiększamy prawdopodobieństwo poprawnego rozpoznania, ale bardzo ograniczamy taką naturalność tej wypowiedzi.

Druga wersja to jest dyktowanie, czyli dowolny długi tekst do różnych zastosowań. I trzecia wersja to jest znajdowanie słów kluczowych. Jest taki nasz najnowszy produkt PATH FINDER i w nim chodzi właśnie o znalezienie słów albo pod kątem analizy jakości osób pracujących gdzieś nad Big Data, takie typu audio, na przykład w centrach telefonicznych, albo ewentualnie o takie rzeczy bardziej detektywistyczne, czyli wyłapywanie jakichś fraudów, czy przestępstw i szukanie różnych słów kluczowych z tym powiązanych. Różnica w porównaniu do dyktowania jest taka, że jeżeli z góry wiemy, że jest jakaś ustalona fraza, której szukamy, to nie szukamy jej w transkrypcji, tylko w siatce słów. To znaczy, że możemy szukać dużo głębiej i jest dużo mniejsza szansa, że przeoczymy takie słowo. Może być trochę więcej fałszywych detekcji, które sobie człowiek zweryfikuje. Natomiast, jeżeli ktoś bazuje na gotowej transkrypcji w systemach Speech Analytics, to tam ma tylko najsilniejszą hipotezę i jest większe ryzyko pominięcia jakichś rozpoznań.

Kolejny system to jest TTS, czyli syntezator. W tej chwili właśnie kończymy naszą nową wersję syntezatora. Już chyba jest dostępne demo na stronie. Robimy to na zasadzie wersji, która może być dedykowana pod jakiś konkretny scenariusz, więc dopuszczamy taką opcję, żeby zarejestrować najważniejsze wypowiedzi. Nasz system bazuje na tym, że jeżeli w swojej bazie ma wypowiedź, która ma być odtworzona, to ją bierze wprost, taką, jaka jest. A jeżeli nie ma, to szuka jak największych kawałków, z których może ją sklejać. To jest więc jego pewnego rodzaju wada w porównaniu do tych najlepszych syntezatorów, natomiast pomimo tej wady może obsłużyć większość przypadków.

Kolejna rzecz to jest biometria głosowa, czyli projekt RUNA. W tej chwili jest w fazie demo i prototypów, nie prowadzimy żadnej działalności wdrożeniowej. To się wiąże trochę z tym, że z naszych obserwacji wynika, że z tych wszystkich technologii głosowych, w tej chwili jest jednak najmniejsze zainteresowanie biometrią. Dlatego trochę odłożyliśmy jąna bok, natomiast w każdej chwili zakładamy powrót do tego systemu. Zajmujemy się głównie w tej chwili właśnie ASR-em i TTS-em.

Ostatnie rozwiązanie, SoundToolKit to trochę osobna bajka. To jest rozwiązanie robione pod gry i pod wirtualną rzeczywistość, gdzie symulujemy dźwięk w przestrzeni, tak jak powinien się odbijać, przechodzić przez ściany, dyfrakcje i wszystkie takie zjawiska fizyczne, które mogą wpływać na dźwięk, tak żeby osiągnąć jak największą immersję.

Wiele rzeczy robicie. Myślę, że warto skomentować syntezator mowy. Wydaje się, że to jest zrozumiałe, ale dodam na wszelki wypadek, że to jest w drugą stronę: macie tekst i próbujecie go przeczytać. A druga rzecz, która wydaje mi się nie do końca zrozumiała. Dlaczego powiedziałeś, że w tej chwili te wszystkie uwierzytelnienia głosem są mniej popularne? Znam w Krakowie startup, znam też jeszcze kilka innych startupów w Polsce, nawet jeden się zgłosił do mnie, ale prosił by nie mówić jego nazwy – oni właśnie już wdrażają taką technologię na produkcję. Tak się zastanawiam, czy to nie jest popularne w Polsce, czyli biznes jeszcze tego nie zauważył, czy nie jest popularne jeszcze na świecie, czyli biznes dopiero się rozkręca – jak myślisz?

Ja mam obserwacje głównie z Polski, to fakt. Na świecie możliwe, że jest to trochę bardziej zaawansowane, aczkolwiek wydaje mi się, że problem polega na tym, że jest to jednak rozwiązanie z branży security, gdzie po prostu dopuszczalne błędy są dużo mniejsze. Jeżeli jest np. rozpoznawanie mowy i tam coś się źle rozpozna, to po pierwsze można jakoś to ukryć poprzez odpowiednie ułożenie scenariusza i to nie jest aż tak dużym problemem. Jeżeli coś się gdzieś źle rozpozna, można prosić o powtórkę i tak dalej. Natomiast jeżeli weryfikacja nastąpi źle, to już są dość poważne problemy. A de facto nie da się stuprocentowo tego zagwarantować.

W odpowiednio dużym systemie, jakieś błędy będą się pojawiać, więc wydaje mi się, że klienci, zwłaszcza duzi klienci, którzy po prostu mają więcej do stracenia, niż do zyskania – myślimy powiedzmy o banku, który ma kilka milionów użytkowników i w tej chwili bazuje na jakiejś innej metodzie weryfikacji, to tak naprawdę przechodząc na nowy, lepszy trochę system, niekoniecznie zdobędzie nowych klientów, w jakichś bardzo dużych ilościach i wykosi konkurencję. Natomiast jeżeli odwrotnie: nowy system okaże się gorszy, to klienci będą odchodzić, prawda? Wydaje mi się, że tutaj działa taki mechanizm. Z tego, co obserwujemy rynek, to generalnie można powiedzieć – nie mówię, że biometria nie cieszy się żadnym zainteresowaniem – ale jeśli chodzi o rozpoznawanie mowy, to mając w tej chwili dwóch business developerów, właściwie nie prowadzimy żadnej aktywnej działalności, bo skupiamy się na obsłudze ruchu, który do nas przychodzi. Jeśli chodzi o biometrię, dużej ilości takich zapytań nie ma. Natomiast jeśli chodzi o ASR, non stop ktoś nas wypytuje o różne możliwości i szuka tych rozwiązań.

No właśnie: możliwości. Porozmawiajmy teraz o praktycznych zastosowaniach. Proszę podaj powiedzmy trzy, pięć praktycznych przykładów, gdzie stosując Wasze produkty, można rozwiązać pewne problemy, no i oczywiście dostarczyć wartość biznesową. Może warto podać przykłady i oczywiste, i mniej oczywiste, żeby naszym słuchaczom, którzy są po drugiej stronie, włączyła się kreatywność.

Takim na pewno najbardziej oczywistym jest różnego rodzaju obsługa klientów, centrale kontaktowe. Tam jest duży zakres tego, co się może dziać. To mogą być odpowiedzi na zapytania klientów, kwestia ściągania różnych długów, wierzytelności, przypomnienia o zaległych płatnościach, zgłaszanie różnych awarii, wysłanie ofert, tutaj tych możliwości jest dość dużo. Druga opcji to sterowanie różnymi urządzeniami lub całym systemami. To jest w tej chwili mniej popularne, ale też już mieliśmy co najmniej jedno takie zapytanie, żeby w magazynie zarządzać głosem pewnymi rzeczami. Jest to o tyle wygodna sprawa, że ludzie, którzy pracują fizycznie, często mają obie ręce zajęte, ekrany dotykowe wymagają tego, że muszą coś odłożyć, nacisnąć i tak dalej. Jeżeli ich zadania są proste, że mają np. przekazać informację typu dwie cyfry, to można zrobić to głosowo, więc to jest taka rzecz, którą robimy.

No i duża działka, w tej chwili chyba najpopularniejsza, najszybciej rosnąca, czyli analiza dużej ilości nagrań między innymi pod kątem kontroli jakości – jeżeli sobie wyobrazimy takie największe polskie call center, najpewniej będzie to Orange, szacuję, że tam na raz prowadzi rozmowy około 1 000 ludzi: 1 000 pracowników Orange i 1 000 klientów. Audio ma to do siebie w porównaniu do obrazu, że jeżeli mamy kontrolować co 1 000 ludzi mówi, no to musimy mieć drugi 1 000. To jest nie do zrobienia właściwie klasycznymi metodami. A tam są rzeczy, które się mogą dziać niewłaściwie, chociażby, przy większości tego typu rozmów, są pewne formuły prawne, które muszą być powiedziane, więc można sprawdzać, czy tak się stało. Można sprawdzać, czy ktoś nie przeklina rozmawiając z klientami i inne tego typu informacje. Oprócz tego możemy też szukać bardziej niebezpiecznych zachowań.

Powiedzmy, że mamy pracownika banku A i w jego rozmowach non stop pada nazwa banku B, to może wzbudzić podejrzenia, skoro on pracuje w banku A, a z Klientami rozmawiał o banku B. To są realne przypadki, że jest duża firma i ma po prostu nieuczciwych pracowników, którzy czasami przekazują różne informacje lub przekazują gdzieś na zewnątrz informacje o klientach. Więc można próbować postawić automat, który będzie wyłapywał rozmowy, w których padają na przykład numery PESEL, czy inne podobne dane. Teraz jeszcze w dobie RODO, poprzeczka idzie w górę w tej kwestii, więc to są podstawowe zastosowania.

Jest wiele obszarów, gdzie to można zastosować. Myślę, że warto jeszcze sprecyzować na jakich językach pracujecie. Do tej pory jest zupełnie oczywiste, że z językiem polskim. Czy pracujecie także z innymi językami? I warto może, przynajmniej trochę, dotknąć tematu jakości, przy okazji powiedz, w jaki sposób mierzycie jakość? Jakie są metryki sukcesu?

W tej chwili pracujemy nad językiem polskim. To się bierze stąd, że dla języka polskiego mamy po pierwsze wiedzę, po drugie dane, więc jak konkurujemy z zagranicznymi firmami nad polskim językiem, to nam to dobrze wychodzi. Aczkolwiek, ze względu na różne otwierające się możliwości, rozpoczynamy też teraz pracę nad angielską wersją i za kilka miesięcy będziemy mieć ASR angielski. W dalszej kolejności rozważamy język hiszpański, albo ukraiński i rosyjski.

Taką standardową miarą jest Word Error Rate, czyli ilość słów błędnie rozpoznanych. Tylko to jest trochę złudne, bo tak naprawdę trudno określić jedną wartość dla systemu, bo bardzo zależy to od scenariusza. Jeżeli na przykład są takie warunki, jakie my mamy tutaj, to rozpoznanie powinno być powyżej 99%. Jeżeli jest niższe, to raczej trzeba uważać, że to jest system słaby, natomiast właśnie bank, o którym ustaliliśmy, że nazwy nie będziemy wymawiać, a który nas testował, tam jeden ze scenariuszy testowych był taki, że pracownik banku został posłany na przystanek tramwajowy i tam rejestrował głośnomówiącym telefonem. Wtedy jakby 99% jest z kolei nieosiągalne. Więc tutaj trzeba się zastanowić, jaki jest scenariusz testowy i wtedy te wartości oczekiwane się bardzo zmieniają.

Słyszałem tę historię z przystankiem i nawet pamiętam taki jeden przykład, kiedy było powiedziane: „Zrobić przelew do Indii” – Wasz system akurat rozpoznał to dobrze, a system konkurencyjny – nie będziemy wymieniać nazwy – rozpoznał to jako: „przelew inny”.

To i tak jeszcze nie tak źle! [śmiech]. A to są takie warunki, w których tak naprawdę ludzie dobrze nie słyszą. Przynajmniej ja, może nie mam bardzo dobrego słuchu, ale jak idę Alejami, czy ulicą Czarnowiejską, to nie jestem w stanie rozmawiać przez telefon. I tutaj trzeba pamiętać o tym, że jak mamy te systemy automatyczne, to raczej nie należy oczekiwać, że one w przewidywalnym czasie będą lepsze niż człowiek, podczas gdy nasze oczekiwania takie są. To też jest dość częsty problem z działaniem w trybie dictation. Jak są takie rozmowy, jak chociażby nasza, która jest już trochę przemyślana, wcześniej omówiona, to jeżeli z tego zrobimy transkrypcję, to będzie wyglądało trochę jak nieumiejętnie napisany tekst przez kogoś, kto nie zna dobrze języka. Natomiast tak duża jest różnica między językiem mówionym, a pisanym. Ludzie często oczekują, że rozpoznana mowa ma mieć jakość tekstu pisanego. I to jest oczekiwanie raczej nie do sprostania.

Też to skomentuję, bo mnie często ludzie pytają, w jaki sposób powstają moje transkrypcje. Są wykobywane przez człowieka. Tutaj pozdrawiam osobę, która mi je pisze! To jest dość żmudna, ciężka praca, żeby faktycznie to nagranie odsłuchać i potem poukładać tekst, tak aby to był przyjemny do czytania.

Dotknęliśmy przynajmniej trochę tematów technicznych. Nie będziemy wchodzić w szczegóły, ale jestem ciekaw, jak to działa pod spodem, czy używacie rozwiązania Open Source, czy piszecie swoje własne narzędzia, w kilku słowach, kilku zdaniach, powiedz, jak to jest.

Generalnie to jedno i drugie. Bazujemy trochę na Open Source`ach, natomiast piszemy też własne rozwiązania. Wywodzimy się ze środowiska akademickiego, więc dla nas analiza różnych publikacji jest chlebem powszednim. Mogłoby się wydawać, że firma Google jest w jakimś sensie naszym konkurencją i mogłaby skrywać swoje rozwiązania ASR przed całym światem, ale oni tego nie robią. Oni bardzo dużo publikują i to raczej nie są takie, powiedzmy „materiały odrzutowe”. Jakieś rzeczy są podejrzewam tajemnicą przedsiębiorstwa, ale bardzo dużo wartościowych prac publikują, można je przeczytać i trochę odtworzyć.

To się bierze stąd, że Google – trzeba pamiętać – jest agencją reklamową i dla nich biznes ze sprzedaży ASR nie jest jakoś strategicznie ważny. Dla nich tak naprawdę najważniejsze jest to, żeby internet rósł. Jak rośnie internet, to rośnie liczba reklam, ich core business też rośnie. Dla nich działalność takich różnych firemek, które sobie robią coś takiego technologicznego, to de facto budowanie ich rynku. Dlatego oni, w przeciwieństwie do innych dużych firm, nie są aż tak zamknięci na swoje rozwiązania.

Ciekawa teoria. Być może faktycznie tak jest. Przejdźmy teraz do warstwy wdrażania. Załóżmy, że teraz słucha nas osoba, której się to spodobało i próbuje chociaż tak mniej więcej oszacować: jak wygląda wdrażanie systemu, ile trwa, jak powinna firma się przygotować? Jaki powinien być budżet na to przeznaczony? Myślę o tym, co jest najważniejsze, jak wygląda utrzymanie tego systemu, czy musicie to co rok sprawdzać, coś zmieniać? Czy po prostu raz wdrażacie i to działa?

Są dwa takie standardy komunikacji serwera ASR z klientem. My obsługujemy oba. Taki, który jest naszym zdaniem lepszy, bo jest po prostu nowszy i ma trochę mniej narzutu różnej pracy do wykonania, to jest ten standard z którego też korzysta Google. Generalnie wpisujemy się w API. Mamy takie doświadczenie, że jeden z naszych potencjalnych klientów, też krakowska firma, dość prężna, 2040.io, którą też chyba znasz, powiedział nam kiedyś, że integrował się z nami 5 minut. To jest taki rekord świata [śmiech], co wynika z tego, że oni wcześniej zrobili sobie integrację z Google, porównywali te dwa systemy i przepięcie się na nas podobno tyle im zajęło.

Natomiast jeżeli jest jakaś taka firma, która jeszcze nie robiła żadnych integracji z ASR, to zajmuje to trochę czasu. To zwykle jest 2-4 tygodnie takiej pracy realnej, zwykle się to przedłuża, bo zazwyczaj jest tak, że osoba, która robi integrację, dostaje jakieś dodatkowe zadania i są problemy z bieżącymi pracami. Ale ogólnie nie jest to taki bardzo skomplikowany system.

Jak się dobrze przygotować do takich rzeczy? Po pierwsze trzeba się zastanowić nad tym, jakie ma się nagrania i sprzęt do nagrań. Zazwyczaj ASR stosuje się do dialogów, więc warto pamiętać żeby rejestrować swoje rozmowy dwukanałowo, bo z tym jest dość dużo problemów. Wielu klientów rejestruje rozmowy w jednym kanale, to jest zmieszane, a później z różnych powodów chcą to rozdzielać i to jest niepotrzebna praca. Jeżeli się z wyprzedzeniem dobrze nagra, to jeden problem ma się z głowy.

Te systemy dopiero teraz wchodzą, więc nie mamy dużego doświadczenia w tym zakresie. Nasze założenie jest takie, że preferujemy model w postaci licencji na 1 rok i później odnawianie licencji co rok za 20% oryginalnej ceny. Zakładamy wtedy coroczny update systemu, żeby był on trochę lepszy. Jeżeli ktoś chce, to można też przez rok, czy nawet trochę krótszy okres czasu zbierać nagrania i je później użyć, żeby zrobić dedykowaną wersję wyćwiczoną pod konkretnego klienta, konkretny scenariusz. Da się to zrobić i to jest też nasza przewaga konkurencyjna, ponieważ ci duzi dostawcy takich opcji nie oferują. Natomiast generalnie w tego typu systemach rzadko kiedy się coś psuje, a jeżeli się psuje, to są to zwykle wycieki pamięci i po prostu trzeba zrestartować serwer. Tak naprawdę restart serwera rozwiązuje 95% problemów.

Restart serwera to zawsze jest najbardziej potężna metoda, żeby wszystko naprawić. Porozmawiajmy jeszcze o dużych graczach. Na przykład Google Cloud, ma taką usługę speech to text i tam też jest język polski. Nawet kiedyś próbowałem i wygląda na to, że to działa.

I to jest właśnie ta różnica między takim podejściem marketingowym i praktycznym, kiedy testujesz coś prostego, to może działać. Jak już rozmawialiśmy o banku, z którym miałem rozmowę, oni też testowali Google i jeszcze kilka innych rozwiązań, i w ich przypadku wygrało Wasze rozwiązanie. Komunikują to też publicznie. I przez moment się zastanawiałem, z czego to może wynikać? Prawdopodobnie z tego, że skupiacie się na jednej rzeczy i robicie to po prostu dobrze. Może jeszcze z czegoś? Jaką tak naprawdę widzicie przewagę konkurencyjną, taką przewagę biznesową?

Jeśli chodzi o Google, to tu jest pierwszy podstawowy showstopper: jest to rozwiązanie chmurowe. Największe zainteresowanie ASR w Polsce okazuje jednak szeroko rozumiana branża finansowa: banki, ubezpieczyciele. Kolejnym w miarę duży sektorem są usługi medyczne, również reagowanie na awarię, plus ewentualnie rozwiązanie dla służb. To wyklucza możliwość wysyłania tych danych na zewnętrzne serwery, więc jest to właśnie ten czynnik, który sprawia że nie traktujemy Google jako konkurencji. Po prostu, to są dwie tak naprawdę rozbieżne biznesowo rzeczy.

Rozwiązanie Google jest raczej stworzone pod małe firmy, które w Polsce zwykle mają dość małe środki i są tak naprawdę słabym klientem. W Polsce dobry klient to są albo duże firmy, albo sektor publiczny, a tutaj raczej nie ma szans na to, żeby zastosowali właśnie serwer Google. W wypadku tego banku, mimo, że cała nasza instalacja i instalacja naszego partnera, ma być zrobiona u nich w serwerowni, zamknięta pod kluczem, to i tak bank zdecydował się przeprowadzić kontrolę Komisji Nadzoru Finansowego. Czy to jest bezpieczne, czy jakieś dane nie wypływają za bardzo na zewnątrz itd. Jest jakaś procedura, ja w to jakoś mocno nie wnikałem, ale pomimo, że wszystko pozostaje wewnątrz serwera, to chyba dlatego że oprogramowanie zostało napisane na zewnątrz, czyli u nas, bank zdecydował, że to sprawdzi i podda się kontroli. Wydaje mi się, że żaden bank w Polsce nawet by się nie odważył zgłosić do KNF-u, że chce wysyłać rozmowy klientów na serwer Google.

Natomiast są też inne rozwiązania on-premisowe. Tam już musimy walczyć jakością rozpoznania i nasza przewaga zazwyczaj polega na tym, że robimy dedykowane rozwiązanie, analizujemy, co tam będzie mówione, robimy jakieś przykładowe nagrania, zbliżone do warunków, do treści, które tam są oczekiwane, robimy analizę i robimy wersję systemu pod konkretnego klienta. Przynajmniej, jeśli jest on tak duży, jak właśnie ten bank, o który chodzi.

Zbliżamy się już końca. Tak myślę, że warto jeszcze dotknąć dość ważnego tematu. Masz duże doświadczenie, w szczególności w rozpoznawaniu mowy. Jakie są największe wyzwania? I trochę o przyszłości: jakie wyzwania widzisz w najbliższych pięciu czy dziesięciu latach?

Myślę, że jesteśmy w tej chwili na takim dość przełomowym etapie. Rozwiązania głosowe mogą się bardzo spopularyzować i wtedy to się może stać taką dominującą technologią. Zapowiedzią tego były sukcesy produktów typu: Amazon Echo, Google Home. Z tego co wiem, to Amazon nie publikuje ilości sprzedanych egzemplarzy. Próbowałem od znajomych pracowników Amazona wyciągnąć tę informację. Oczywiście, to się nie udało, ale generalnie ich mimika sugerowała, że jest bardzo duża, więc z mojej perspektywy jest jakaś nadzieja, że to może być coś, co zastąpi istniejące rozwiązania, taki mityczny amerykański the next big thing. Oznaczałoby to, że w perspektywie, załóżmy trzech lat, może się zrobić taki boom jak było w przypadku smartfonów kilka lat temu. Następuje nagle całkowite przeczesanie rynku, giganci znikają, a relatywnie małe firmy stają się prawie monopolistami. Czy tak się wydarzy – to się okaże. Na pewno głos jest takim bardzo naturalnym, wygodnym środowiskiem dla człowieka.

Jest też kwestia tego, że jednak oczekiwania względem smartfonów – czytałem taki raport – są ze sobą sprzeczne, bo z jednej strony ludzie chcą, żeby dłużej działały bez ładowania, a z drugiej strony, żeby ekrany były większe. Wydaje mi się, że dotarliśmy do takiej sytuacji, gdzie trudno kontynuować rozwój smartfonów tak, aby sprostał oczekiwaniom. Wydaje mi się, że gdyby była możliwość zrobienia interfejsów głosowych, które potrafią pełnić te funkcjonalności, które mają smartfony, to jest to szansa na dużą nową technologię.

Tylko wyobraźmy sobie na przykład, czy jesteśmy w stanie zrobić wersję Ubera bez monitora, tak żeby wszystko było dyktowane? Na przykład użytkownik chce się dowiedzieć, czy samochód jest gdzieś daleko albo gdzie ma podejść, to pyta się głosowo, a automat odpowiada: „obróć się w tę stronę”, „idź tam” itd. No i jeżeli tutaj odpowiedź jest pozytywna i że da się coś takiego zrobić, to wydaje mi się, że ekrany dotykowe mogą wtedy zniknąć. Aczkolwiek nie jest to takie oczywiste. Przyszłość pokaże.

Bardzo popieram to, co mówisz. Wydaje mi się że interfejs się zmieni. Być może zajmie to więcej niż 5 lat, być może za 5 lat to już będzie takie bardziej oczywiste. Prawdopodobnie tak się stanie, że ludzie będą częściej posługiwać się głosem, bo to jest proste i naturalne. Nawet nawiązując do Ubera, chciałabym czasem powiedzieć: „Uber, przyjedź tutaj!”, zamiast tego, żeby szukać aplikacji, czekać kilka sekund, klikać, potem ta aplikacja się otwiera, nadal czekasz, potem szuka lokalizacji i cały czas musisz być z tym telefonem. Teraz, jak miałbym do wyboru, żeby tylko powiedzieć coś, a potem niech ta aplikacja sobie startuje spokojnie kilka sekund, poszukuje kierowcy itd., dla mnie to byłoby OK. Co prawda czasem jest jednak wygodniej popatrzyć na mapce, gdzie jest kierowca, niż słuchać: „kierowca jest w odległości 150 metrów”, „popatrz w lewo”. Być może jest to kwestia przyzwyczajenia.

Wrócę jeszcze do poprzedniego pytania, bo powiedziałeś o możliwościach, a jakie są wyzwania? Rozmawiałem z Tobą, jak spotkaliśmy się wcześniej, że teraz do Polski przyjeżdża dużo osób z Ukrainy, które nie mówią dobrze po polsku i dlatego Wasz system czasem się gubi. I to, co robicie, to próbujecie się adaptować pod zmiany rynku. I to jest też wyzwanie. Opowiedz jeszcze o ciekawych przypadkach z Twojego życia, związanych z wyzwaniami, które macie na co dzień.

Na pewno jest właśnie kwestia języków, również rzadkich języków, które nie są jeszcze obsługiwane. Jest na pewno kwestia pracy w szumie, zwłaszcza jeśli kilka osób mówi, również kwestia interpretacji, to jest ta warstwa wyżej, ale tutaj myślę, że jest bardzo dużo do zrobienia, tak bardziej na poziomie NLP, takiego postprocessingu rozpoznawania mowy.

Kwestia obcokrajowców, którzy mówią po polsku jest coraz szersza. My się już u naszych klientów z takimi rozmowami spotkaliśmy, uczyliśmy się, jak je analizować. Akurat niedawno obserwowałem z dość dużą ciekawością taką rozmowę w azjatyckiej restauracji niedaleko naszej firmy, w której – w przeciwieństwie do większości restauracji zatrudniających jednak Polaków jako kelnerów – jest taka pani z Azji, nie wiem z jakiego kraju, która mówi trochę po polsku. W pobliżu jest dość dużo korporacji. Raz widziałem, że rozmawiała właśnie tym swoim polskim z kimś chyba z Indii, kto też mówił trochę po polsku. No i poczułem wtedy, że obcokrajowcy jednak uczą się polskiego i w momencie, w którym, powiedzmy, Wietnamka rozmawia z Hindusem po polsku, to jest to dość ciekawe zjawisko.

Ale oznacza to też, że właśnie to są rzeczy, które należy w tych systemach uwzględniać, bo to będzie miało coraz większe znaczenie. Ci ludzie przychodzą do przychodni i przychodnie też mają problemy z takimi osobami, bo one chcą być obsłużone. Czasami mówią że znają język polski, później się okazuje, że różnie z tym bywa i tutaj też wydaje mi się, że jakieś rozwiązania, może takie bardziej w stronę automatycznego tłumaczenia będą się pojawiać.

To jest ciekawe – nie wiem jak to w sumie nazwać – bo w sumie angielski z Indii, to hinglish, a tutaj będzie… nawet nie wiem jak to słowo nazwać, ale pewnie będzie to jakaś kombinacja kilku języków. Może być wesoło. Ostatnie pytanie już na dzisiaj. Jak można się Bartku z Tobą skontaktować i gdzie obecnie można znaleźć Cię w sieci?

Najprościej poprzez e-mail: bartosz.ziolko [małpka] techmo.pl.

Dzięki wielkie za Twój czas, chęć podzielenia się wiedzą i wszystkiego dobrego!

Ja również dziękuję za zaproszenie.

Bartek przygotował dla Ciebie prezent o zastosowaniu ASR: przyszłe, przeszłe i teraźniejsze. Żeby go dostać, wystarczy zapisać się na newsletter.

Opowiem trochę o moich przemyśleniach, być może też masz podobne zmartwienia. Na początku lipca miałem okazję uczestniczyć w dyskusji dotyczącej strategii sztucznej inteligencji dla Polski, która odbyła się w Ministerstwie Przedsiębiorczości i Technologii i była poprowadzona przez dyrektora Departamentu Innowacji. Ku mojemu zaskoczeniu, dyrektor poprowadził dyskusję dość ciekawie i sprawnie. Skąd to zaskoczenie? Bo spodziewałem się, że będzie dużo pogadanek i biurokracji, natomiast zobaczyłem otwartość do rozmowy oraz świadomość wszystkich problemów i ograniczeń. W prezentacji wspomniano między innymi o tym, że większość firm w Polsce działa w sposób transakcyjny z zerowym zaufaniem do siebie. Większość firm próbuję wyciągnąć coś tylko i wyłącznie dla siebie, zamiast pomyśleć o tym, jak zrobić coś fajnego wspólnie.

Dlatego, żeby budować poważne i skomplikowane rozwiązania, również oparte o sztuczną inteligencję, powinna zaistnieć pewna kultura współpracy, otwartość do współpracy i myślenie długofalowe, a nie tylko „urwać” trochę więcej „na teraz”. Nawiążę trochę do innego tematu, który w pewnym sensie pokazuje ten problem.

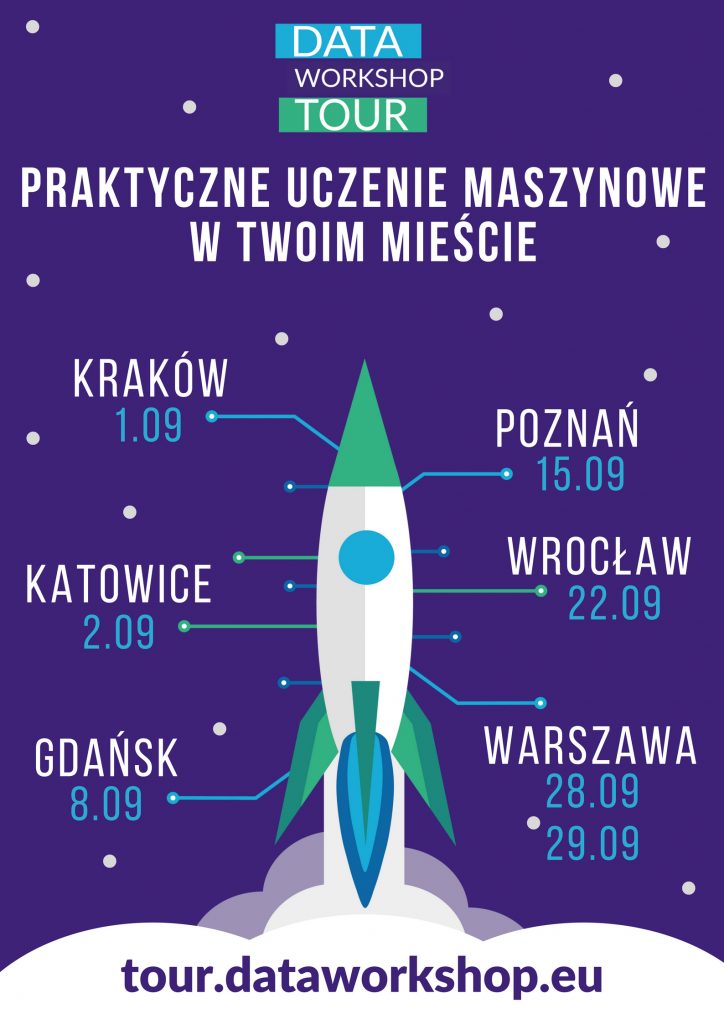

We wrześniu organizujemy DataWorkshop Tour po Polsce z jednodniowym szkoleniem wprowadzającym do uczenia maszynowego. Odwiedzimy 6 miast i w Warszawie szkolenie odbędzie się dwa razy.

Jestem samoukiem, przepuściłem przez siebie dość dużo informacji i zostawiłem najciekawsze. Chcę podzielić się z Tobą moim sposobem myślenia, który może Ci pomóc skutecznie i praktycznie wejść do tematu uczenia maszynowego. Szacuje się, że zawód specjalisty uczenia maszynowego będzie jednym z najlepiej opłacanych zawodów w najbliższej przyszłości. Natomiast chodzi o coś więcej niż tylko pieniądze, warto robić rzeczy, które masz w sercu. Masz unikalną okazję małym kosztem sprawdzić, czy uczenie maszynowe jest dla Ciebie. Do zobaczenia we wrześniu.

Robimy to wspólnie z lokalnymi partnerami. W Krakowie naszym partnerem będzie Miquido. To jest ciekawe, kiedy rozmawiając o współpracy, czujesz, że każda strona myśli o tym, jak to zrobić lepiej i dodaje od siebie kolejne wartości dla uczestników. Dla mnie to jest mega inspirujące, wiem, że firma ostatnio fajnie się rozwija i jak łatwo się domyślić, ciężko to nazwać przypadkiem. Życzyłbym sobie, aby w Polsce było więcej firm, które chcą współpracować i działać wspólnie.

Natomiast widzimy bardzo dużo antywzorców, kiedy mimo chęci na początku, nagle wątek jest gdzieś ucinany lub skomplikowane procesy blokują rozpoczętą rozmowę. Na razie nie podaję nazw firm, chociaż może warto byłoby je wymienić, co o tym myślisz? Mam wrażenie, że top menedżerowie lub prezesi tych firm mogą słuchać tego podcastu i myśleć, że w ich firmie jest lepiej, a niestety tak nie jest.

Brakuje nam jeszcze dwóch partnerów. Ciekawy jestem, czy są technologiczne firmy otwarte na współpracę w Poznaniu i Gdańsku? Jeśli znasz takie, a może nawet je prowadzisz – to proszę, daj mi o tym znać. Zróbmy razem fajne wydarzenie.

Jak myślisz, co powinno się stać, żeby zmieniła się kultura współpracy pomiędzy firmami?

Jeszcze na koniec zaprosiłem do podcastu Agę, która jest absolwentką kursu praktyczne uczenie maszynowe na DataWorkshop. Aga trochę się przejmowała, bo wcześniej to ona zwykle słuchała podcastu, natomiast teraz już miała w nim wystąpić. Wydaje mi się, że w rozmowie była trochę spięta, ale za to autentyczna. Zapraszam do wysłuchania.

Na koniec zaprosiłem jeszcze Agę, która jest absolwentką kursu „Praktyczne uczenie maszynowe” na DataWorkshop i brała udział w drugiej edycji. Aga trochę się przejmowała, więc bardzo Cię proszę, wybacz jej to zdenerwowanie. Wcześniej słuchała podcastu, więc była po drugiej stronie, teraz znalazła się po tej stronie, która nadaje. Natomiast mimo tego, że się przejmowała, to wydaje mi się, że ta rozmowa daje wartość, bo jest autentyczna – jak wiesz, JA uwielbiam autentyczność. Zapraszam do wysłuchania.

Cześć Aga, przedstaw się kim jesteś, czym się zajmujesz, gdzie mieszkasz?

Cześć Vladimirze, nazywam się Agnieszka Weiske, jestem z Wrocławia, pracuję w firmie Nokia i obecnie jestem na stanowisku team lidera zespołu deweloperów.

Co ostatnio czytałaś?

Z książek, które ostatnio przeczytałam i mogłabym polecić innym, jest między innymi „Deep thinking” znanego szachisty Garriego Kasparowa – opowiada o tym jak grał z Deep Blue, o swojej przegranej i co wtedy się działo.

Następna książka to jest „Twój mózg w działaniu” Davida Rocka, to jest książka, która opowiada o tym, jak pracuje nasz mózg – dla mnie osobiście też było dużo przydatnych informacji: jak organizować sobie czas, jak działać w momencie presji czasu, gdy trzeba szybko rozwiązać jakieś sprawy, przemyśleć je sobie. Jest też ciekawie napisana, bo są postaci, które mają różne zadania do wykonania i muszą im sprostać – a mając wiedzę o tym, jak działa mózg, po prostu jest im łatwiej.

Kolejną pozycją jest „Twoje drugie życie zaczyna się, kiedy zrozumiesz, że życie jest tylko jedno”. Jest to książka Raphaëlle Giordano. Opowiada o dziewczynie, która jest na etapie zmian w życiu, poszukuje zajęcia, które jest bliższe jej predyspozycjom i z którego może czerpać korzyści. Książka jest super dla osób, które są na takim etapie życie, że chciałyby robić coś, co im przynosi radość.

W tej pierwszej książce „Deep thinking” było bardzo fajne rozmyślenie, między innymi był tam przykład jak ludzie reagowali, jak to będzie, że winda będzie bez człowieka specjalista w środku – wtedy to było odbierane jako bardzo szalona myśl, a teraz śmiejemy się z tego, bo to jest normalnie. To oznacza, że wiele rzeczy, które teraz są dla nas szalone, jak autonomiczne samochody, to już dla naszych dzieci, a tym bardziej dla naszych wnuków, będzie bardzo oczywiste i w ich odczuciu nie można inaczej. Bardzo Ci dziękuję za to polecenie.

Jeżeli chodzi o tę książkę o mózgu, to jest strasznie ciekawa lektura, szczególnie że mózg dla mnie jest jedną z największych inspiracji, szczególnie to jak funkcjonuje – bo każdy z nas posiada mózg, ale tak naprawdę nikt nie wie, jak on działa i próbujemy się zachowywać empirycznie, żeby wykorzystywać go w pewnym sensie efektywnie.

Jak to się stało, że zainteresowałaś się tematem uczenia maszynowego?

Myślę, że trzeba byłoby sięgnąć aż do dzieciństwa. Pierwszą inspiracją była książka mojego taty „Nowoczesne zabawki”, której autorem jest Janusz Wojciechowski. Książka została wydana w 1966 roku i zawiera sporo przykładów układów elektronicznych do wykonania samemu w domu. Między innymi były też roboty i myślę, że to był taki początek, taka pierwsza inspiracja robotami. Rok temu słuchałam podcastu, w którym promowany był język R i od tamtego momentu zaczęłam szukać informacji o machine learningu, o sztucznej inteligencji. Zaczęłam od czytania książki „Naczelny algorytm” Pedro Domingosa i poszukiwałam kolejnych informacji na ten temat, próbując zgłębiać temat.

Prawdopodobnie w taki sposób trafiłaś na kurs praktycznego uczenia maszynowego na DataWorkshop.

Tak. Po kilku miesiącach poszukiwań, prób wykonywania zadań, które ludzie opisywali na blogach, stwierdziłam, że nauka idzie za za wolno i potrzebuję pójść na kurs, żeby mieć lepszą wiedzę i szybciej ją zdobyć.

Co Ci się najbardziej spodobało na kursie?

Z perspektywy czasu mogę powiedzieć, że wartościowy dla mnie to był sposób ułożenia materiałów od ogółu do szczegółu, z każdym kolejnym krokiem była większa trudność i dokładniej poznawaliśmy zagadnienia.

A czy było coś, co Cię zaskoczyło?

Bardzo miłym zaskoczeniem był Twój sposób komunikowania się z nami, taka otwartość, bezpośredniość, to, że nie mieliśmy żadnego problemu, żeby w czasie trwania kursu odezwać się, poprosić o pomoc. Nie było też takiego dystansu, jaki jest między ekspertem a uczniem, więc nie miałam obaw, czy mogę się o coś zapytać – to było super.

A jak wyglądała Twoja znajomość Pythona? Czy już wcześniej miałaś kontakt z tym językiem, czy to była Twoja pierwsza przygoda?

Wcześniej już pisałam w Pythonie, ale nie komercyjnie, tylko na potrzeby własne jak automatyzacja moich codziennych zadań. Trochę znałam Pythona, ale musiałam się doszkalać w trakcie trwania kursu.

Jaki jest następny krok? Co zamierzasz zrobić z tą wiedzą, którą uzyskałaś na kursie?

W firmie jest grupa entuzjastów uczenia maszynowego, regularnie spotykamy się i na tych spotkaniach są proponowane projekty do rozwiązania. Kolejnym krokiem dla mnie jest wzięcie udziału w tym projekcie i realizacja własnych projektów w przyszłości.

Jak myślisz, kto skorzysta na przerobieniu tego kursu?

Chyba każdy [śmiech]. W tej chwili rozmawiam o uczeniu maszynowym z wieloma osobami, w każdym widzę jakieś zainteresowanie tematem. Z grona programistów większość ludzi jest ciekawa, nawet bardzo ciekawa tego, co jest dalej, czego się można dowiedzieć, nauczyć i proponuję im właśnie ten kurs.

Trzynastego października będzie konferencja, która przede wszystkim zrzesza absolwentów kursu, ale również dla osób, które chcą poznać uczenie maszynowe. Być może ci ludzie już pracują w tym obszarze, ale potrzebują zrobić krok do przodu, czyli z middle’a przeskoczyć na seniora – czy będziesz na tej konferencji? Jak myślisz, co byłoby największą wartością, jeśli pojawiłoby się na tej konferencji?

Wybieram się na tę konferencję, w tej chwili bardzo pomocne są przykłady projektów, które są realizowane przez małe zespoły, pojedyncze osoby, coś, co dałoby mi pewność, że ja też mogę takie projekty zrealizować i nauczyć się od tych osób, jak stawiać pierwsze kroki.

Już ostatnie pytanie: jak można Cię znaleźć w sieci, jeśli ktoś chciałby z Tobą porozmawiać?

Najprościej mnie znaleźć na LinkedInie i na Facebooku.

Aga, dziękuję Ci bardzo za Twój czas i chęć podzielenia się Twoją opinią. Do zobaczenia w październiku na konferencji, a może jeszcze gdzieś.

Dziękuję bardzo za zaproszenie i do zobaczenia.